{

# Spark 相关配置

spark: {

app: {

name: Nebula Exchange 3.0.0

}

driver: {

cores: 3

maxResultSize: 1G

}

executor: {

memory:6G

}

cores: {

max: 16

}

}

# NebulaGraph 相关配置

nebula: {

address:{

# 指定 Graph 服务和所有 Meta 服务的 IP 地址和端口。

# 如果有多台服务器,地址之间用英文逗号(,)分隔。

# 格式:"ip1:port","ip2:port","ip3:port"

graph:["ngraph01:9669","ngraph02:9669","ngraph03:9669"]

meta:["ngraph01:9559","ngraph02:9559","ngraph03:9559"]

}

# 指定拥有 NebulaGraph 写权限的用户名和密码。

user: root

pswd: nebula

# 指定图空间名称。

space: xygraph

connection: {

timeout: 3000

retry: 3

}

execution: {

retry: 3

}

error: {

max: 32

output: /tmp/errors

}

rate: {

limit: 1024

timeout: 1000

}

}

# 处理点

tags: [

# 设置 Tag player 相关信息。

{

# 指定 NebulaGraph 中定义的 Tag 名称。

name: APPL

type: {

# 指定数据源,使用 JSON。

source: json

# 指定如何将点数据导入 NebulaGraph:Client 或 SST。

sink: client

}

# 指定 JSON 文件的路径。

# 如果文件存储在 HDFS 上,用双引号括起路径,以 hdfs://开头,例如"hdfs://ip:port/xx/xx"。

# 如果文件存储在本地,用双引号括起路径,以 file://开头,例如"file:///tmp/xx.json"。

path: "hdfs://xydwns/tmp/tag/APPL.json"

# 在 fields 里指定 JSON 文件中 key 名称,其对应的 value 会作为 NebulaGraph 中指定属性的数据源。

# 如果需要指定多个值,用英文逗号(,)隔开。

fields: [id6_scr,appliedId,product_id,ocr_scr,home_scr, credit_limit]

# 指定 NebulaGraph 中定义的属性名称。

# fields 与 nebula.fields 的顺序必须一一对应。

nebula.fields: [id6_scr,appliedId,product_id,ocr_scr,home_scr, credit_limit]

# 指定一个列作为 VID 的源。

# vertex 的值必须与 JSON 文件中的字段保持一致。

# 目前,NebulaGraph 3.2.1仅支持字符串或整数类型的 VID。

vertex: {

field:id

}

# 指定单批次写入 NebulaGraph 的最大点数量。

batch: 2000

# 指定 Spark 分片数量。

partition: 60

}

]

}

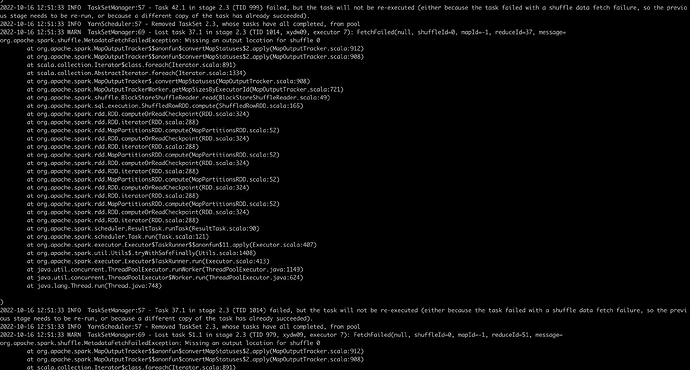

nohup spark-submit --class com.vesoft.nebula.exchange.Exchange --master yarn --name CBK_SENIOR_REL --num-executors 3 --executor-memory=30G --executor-cores 60 --conf spark.driver.extraClassPath=./ --conf spark.executor.extraClassPath=./ nebula-exchange_spark_2.2-3.0.0.jar -c APPL.conf >> APPL.log &

数据进去了一点 过一会任务失败