提问参考模版:

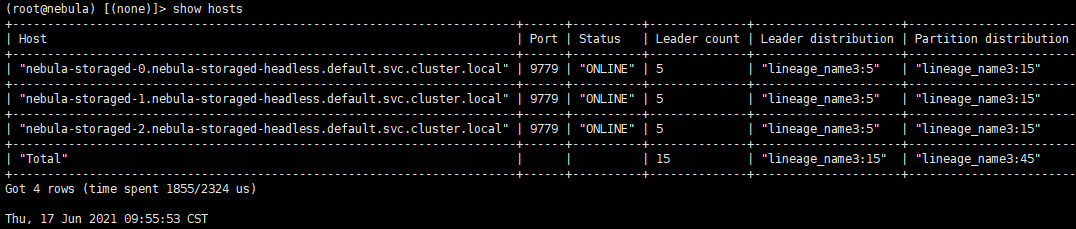

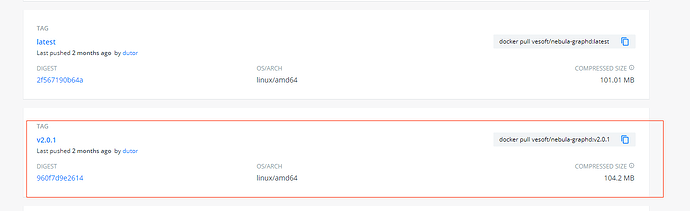

- nebula 版本:2.0.1

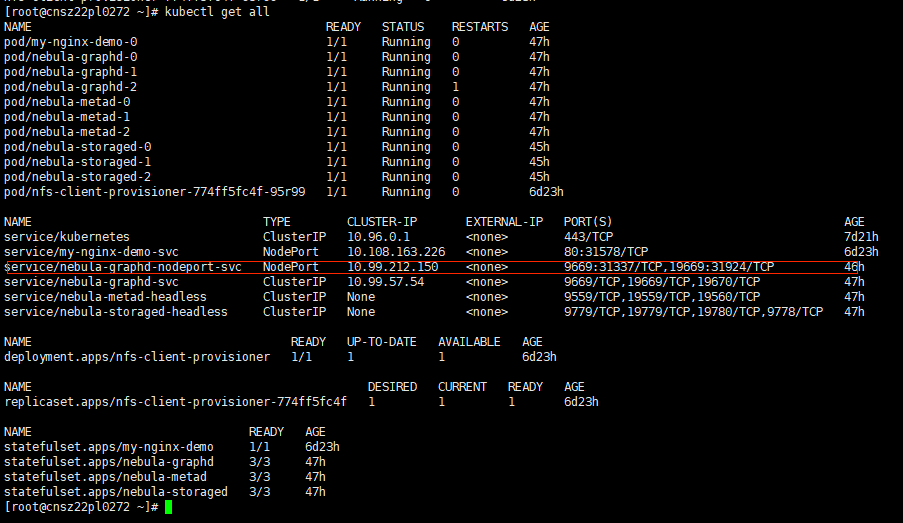

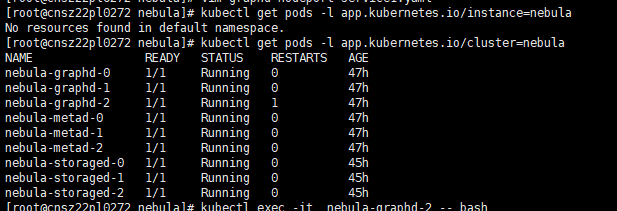

- 部署方式(分布式 / 单机 / Docker / DBaaS):分布式nebula operator

- 是否为线上版本:Y

使用java-client,获取一个session ,持续的写入了三个半小时,后报错,

ps:这一套java-client写入代码,如果是持续写入物理机rpm安装的集群,没有任何问题,但是写入k8s里面nebula-operator的,集群不稳定,长时间写入后集群就报错,报错的信息也看不懂,

[INFO ][2021-06-16 15:29:48,784][com.sf.nebula.FileUtilsTest] :start

[INFO ][2021-06-16 15:29:57,001][com.sf.nebula.util.NebulaGraphUtil] :NebulaGraphUtil create appMode=k8s space=lineage_name3

[INFO ][2021-06-16 15:29:57,733][com.vesoft.nebula.client.graph.net.NebulaPool] :Get connection to 10.202.77.197:31337

[INFO ][2021-06-16 15:30:02,495][com.sf.nebula.FileUtilsTest] :handler data total :500

[INFO ][2021-06-16 15:30:08,729][com.sf.nebula.FileUtilsTest] :handler data total :1000

.

.

.

[INFO ][2021-06-16 19:05:54,391][com.sf.nebula.FileUtilsTest] :handler data total :245000

[INFO ][2021-06-16 19:06:07,004][com.sf.nebula.FileUtilsTest] :handler data total :245500

[INFO ][2021-06-16 19:07:02,387][com.sf.nebula.FileUtilsTest] :handler data total :246000

[INFO ][2021-06-16 19:07:12,193][com.sf.nebula.FileUtilsTest] :handler data total :246500

[INFO ][2021-06-16 19:07:21,558][com.sf.nebula.FileUtilsTest] :handler data total :247000

[INFO ][2021-06-16 19:08:02,881][com.sf.nebula.FileUtilsTest] :handler data total :247500

[INFO ][2021-06-16 19:08:29,550][com.sf.nebula.FileUtilsTest] :handler data total :248000

[INFO ][2021-06-16 19:09:26,345][com.sf.nebula.FileUtilsTest] :handler data total :248500

[ERROR][2021-06-16 19:10:00,174][com.sf.nebula.util.NebulaGraphUtil] :Expected protocol id ffffff82 but got 48

com.vesoft.nebula.client.graph.exception.IOErrorException: Expected protocol id ffffff82 but got 48

at com.vesoft.nebula.client.graph.net.SyncConnection.execute(SyncConnection.java:74)

at com.vesoft.nebula.client.graph.net.Session.execute(Session.java:56)

at com.sf.nebula.util.NebulaGraphUtil.executeWith3Tries(NebulaGraphUtil.java:115)

at com.sf.nebula.util.NebulaGraphUtil.executeWith3Tries(NebulaGraphUtil.java:134)

at com.sf.nebula.handler.StatementHandler.buildNebulaStatement(StatementHandler.java:41)

at com.sf.nebula.sink.NebulaSink.invoke(NebulaSink.java:93)

at com.sf.nebula.FileUtilsTest.main(FileUtilsTest.java:49)

[ERROR][2021-06-16 19:10:00,177][com.sf.nebula.util.NebulaGraphUtil] :java.net.SocketException: Connection reset by peer: socket write error

com.vesoft.nebula.client.graph.exception.IOErrorException: java.net.SocketException: Connection reset by peer: socket write error

at com.vesoft.nebula.client.graph.net.SyncConnection.execute(SyncConnection.java:74)

at com.vesoft.nebula.client.graph.net.Session.execute(Session.java:46)

at com.sf.nebula.util.NebulaGraphUtil.executeWith3Tries(NebulaGraphUtil.java:115)

at com.sf.nebula.util.NebulaGraphUtil.executeWith3Tries(NebulaGraphUtil.java:134)

at com.sf.nebula.handler.StatementHandler.buildNebulaStatement(StatementHandler.java:41)

at com.sf.nebula.sink.NebulaSink.invoke(NebulaSink.java:93)

at com.sf.nebula.FileUtilsTest.main(FileUtilsTest.java:49)

[ERROR][2021-06-16 19:10:00,177][com.sf.nebula.util.NebulaGraphUtil] :executeWith3Tries failed, msg=Storage Error: part: 15, error: E_RPC_FAILURE(-3)., nGql=DELETE VERTEX "bdp.dm_pcss.pcss_waybill_route_coustom_one_temp3"; DELETE EDGE produce "bdp.dm_pcss.pcss_waybill_route_coustom_one_to_tj" -> "bdp.dm_pcss.pcss_waybill_route_coustom_one_temp3"; DELETE EDGE contain "bdp.dm_pcss.pcss_waybill_route_coustom_one_temp3" -> "bdp.dm_pcss.pcss_waybill_route_coustom_one_temp3.actualweight"; DELETE VERTEX "bdp.dm_pcss.pcss_waybill_route_coustom_one_temp3.actualweight";

com.vesoft.nebula.client.graph.exception.IOErrorException: java.net.SocketException: Connection reset by peer: socket write error

at com.vesoft.nebula.client.graph.net.SyncConnection.execute(SyncConnection.java:74)

at com.vesoft.nebula.client.graph.net.Session.execute(Session.java:46)

at com.sf.nebula.util.NebulaGraphUtil.executeWith3Tries(NebulaGraphUtil.java:115)

at com.sf.nebula.util.NebulaGraphUtil.executeWith3Tries(NebulaGraphUtil.java:134)

at com.sf.nebula.handler.StatementHandler.buildNebulaStatement(StatementHandler.java:41)

at com.sf.nebula.sink.NebulaSink.invoke(NebulaSink.java:93)

at com.sf.nebula.FileUtilsTest.main(FileUtilsTest.java:49)

[ERROR][2021-06-16 19:10:00,179][com.sf.nebula.util.NebulaGraphUtil] :java.net.SocketException: Connection reset by peer: socket write error

com.vesoft.nebula.client.graph.exception.IOErrorException: java.net.SocketException: Connection reset by peer: socket write error

at com.vesoft.nebula.client.graph.net.SyncConnection.execute(SyncConnection.java:74)

at com.vesoft.nebula.client.graph.net.Session.execute(Session.java:46)

at com.sf.nebula.util.NebulaGraphUtil.executeWith3Tries(NebulaGraphUtil.java:115)

at com.sf.nebula.util.NebulaGraphUtil.executeWith3Tries(NebulaGraphUtil.java:134)

at com.sf.nebula.handler.StatementHandler.buildNebulaStatement(StatementHandler.java:41)

at com.sf.nebula.sink.NebulaSink.invoke(NebulaSink.java:93)

at com.sf.nebula.FileUtilsTest.main(FileUtilsTest.java:49)