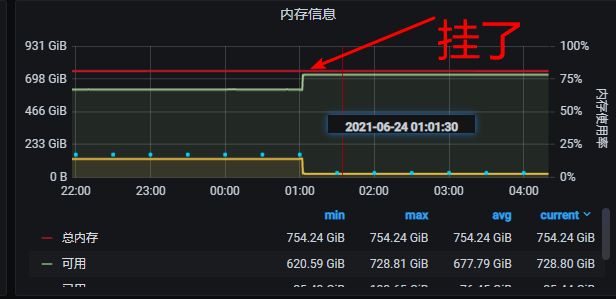

问题, 我算是已经完全理清了, 昨天是导入时候的wal日志文件打开太多报错, (今天凌晨1点是自动清理wal日志文件的时候又打开太多, 也导致其中2台storage节点挂了) 这个还不是自动清理wal时候报错的, 还是 导入数据报错的, 我刚刚看到了我们有凌晨1点的定时任务写入数据

疑问: 我能手动把wal下的日志全部删除吗?

我就是简单的用你们官网的例子代码入库的, 其实最核心的和nebula最终交互是你们写的

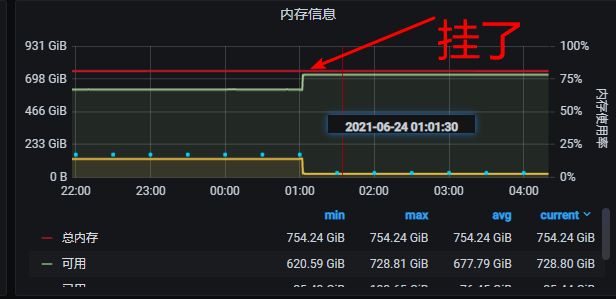

问题, 我算是已经完全理清了, 昨天是导入时候的wal日志文件打开太多报错, (今天凌晨1点是自动清理wal日志文件的时候又打开太多, 也导致其中2台storage节点挂了) 这个还不是自动清理wal时候报错的, 还是 导入数据报错的, 我刚刚看到了我们有凌晨1点的定时任务写入数据

疑问: 我能手动把wal下的日志全部删除吗?

我就是简单的用你们官网的例子代码入库的, 其实最核心的和nebula最终交互是你们写的