- nebula 版本:(为节省回复者核对版本信息的时间,首次发帖的版本信息记得以截图形式展示)

- 部署方式(分布式 / 单机 / Docker / DBaaS):单机

- 是否为线上版本:Y / N N

- 硬件信息

- 磁盘( 推荐使用 SSD) 300G

- CPU、内存信息 50核100G

- 问题的具体描述

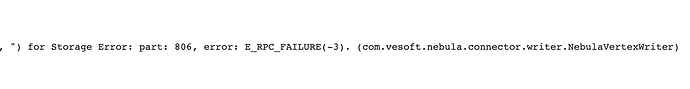

- 相关的 meta / storage / graph info 日志信息(尽量使用文本形式方便检索)

使用 spark connector。

spark cores 加大后(60*8),存储10亿数据,后半段会出现部分插入失败的情况;加大spark cores 核数,发现失败情况更多,查看日志发现插入失败的数据会报错 E_RPC_FAILURE(-3),请问瓶颈是在哪里,如何应对,谢谢。