服务状态都是正常的, 这个 open_files 我没配置,使用的是默认配置文件。 这个配置多大合适呢?

–rocksdb_db_options={“max_open_files”:“1000”}

配置了1000,还是一样的错误

65535 ,挺大的啊

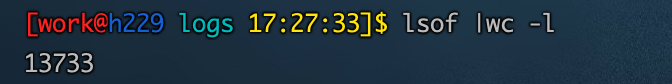

65535是很大了,你看下当前已经打开的file数

只有1万多

那也不是openfile的问题啊,你这情况稳定复现么。 看着像是 客户端给服务端发送请求的时候,服务端连接断了

spark-connector 读取nebula 一直是这种情况,从没执行成功过

边、点 能正常获取元数据,就是读不到真正的数据

你的nebula storage 服务重启一下, 我这边用2.1.0的spark-connector去读 2.0.1的Nebula和nightly的都可以读成功的,socket 感觉还是环境有问题。

还是不行,我能在本地用spark connector正常warite点,但是然后spark connector从nebula read还是报一样的错。

你是在本地电脑执行的任务么?

当我跑这个任务的时候,lsof 命令:疯狂显示TCPv6 连接9779端口信息

提供操作系统版本,发行版,容器(如有)版本的信息

Linux version 3.10.0-1160.6.1.el7.x86_64 (mockbuild@kbuilder.bsys.centos.org) (gcc version 4.8.5 20150623 (Red Hat 4.8.5-44) (GCC) ) #1 SMP Tue Nov 17 13:59:11 UTC 2020

Linux h229 3.10.0-1160.6.1.el7.x86_64 #1 SMP Tue Nov 17 13:59:11 UTC 2020 x86_64 x86_64 x86_64 GNU/Linux

CentOS Linux release 7.9.2009 (Core)

您好,我也是windows本地的spark,也从来没有读正确过,你是单机版本还是docker部署的呢,这两种我都尝试了,都从来没有正确读过。单机版本按照其他帖子修改了local-host/以及meta-server-addrs,反而查数据都报错了,写的话倒是正确的,最终您的问题解决了吗?

你把你的部署、show hosts结果、spark 代码配置发一下,这个问题就是网络不互通导致的,很有可能是ip及端口号配错或telnet无法连接ip port。

谢谢啦,解决啦,主要是space是改ip之前创建的

哈哈哈哈 和我一样

太难了

此话题已在最后回复的 30 天后被自动关闭。不再允许新回复。