这边是每个tag ,一个spark 任务的。然后文件合并到一个文件夹里面一起下载

还是导入 INGEST 是有验证同一个spark 任务,不同spark 不行吗???

没有吧 多个Spark 任务用的 rocksdb Java JNI 版本是一样的吧

不要吧?? 可以确定一下吗

这边需要多个任务加快生成速度。麻烦帮确定一下

sprak job 启动都是同一个exhange,只是循环多个任务。现在是发现多个任务导入可以,但是有时出现部分少数sst文件失败问题导致数据不完整缺失一部分,不是说不行,有点奇怪,这边再多测试验证一下吧,

1)还有用console 命令行的下载 命令,download 只有对应节点数量的分区目录数比如storage 12 个。download 命令就12 文件夹,但是这边生成sst 文件是48 个分区文件夹。你们这个下载命令是不是只下载部分分区数据????,导入后现在显示数据不全缺少很多数据

2) INGEST 慢,是不是sst文件要按照tag ,edge 内部id 排序导入才会快

上面2个问题也麻烦帮回复确认一下

现在的INGEST 已经按照key 进行排序了,主要是可能会有overlap,所以需要判断

载命令是不是只下载部分分区数据? 下载过程中间失败了?

下载过程数据多了就卡主不动了,也没失败日志。

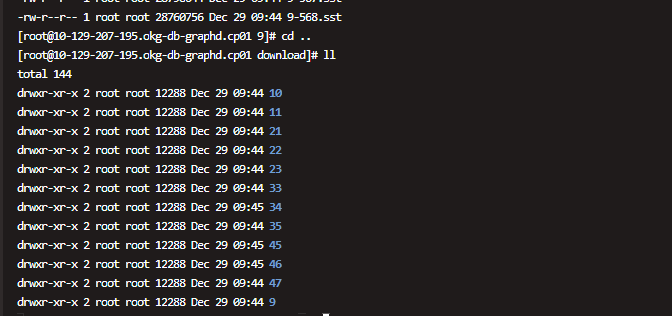

如下面 第一个是下载后的只有12分区文件夹

但是hdfs 上生成是48 个分区文件夹,我想问的是下载命令下载结果就是这样的吗,不是每个节点都下载hdfs 上全部分区数据吗,这样导入后数据是否会少,现在测试结果数据缺少一部分

下载使用的是 Hadoop Java 命令行实现的,如果卡住了,检查网络环境吧。

每个节点并不是下载所有SST文件,而是仅下载包括该节点所持有的的分区的SST文件。

导入数据是否会少?应该不会,除非下载的文件不是完整的。