nebula 版本:2.0.1

部署方式(分布式 / rpm

是否为线上版本:Y

硬件信息

磁盘ssd 500G

CPU 16C、32G 内存信息

问题的具体描述

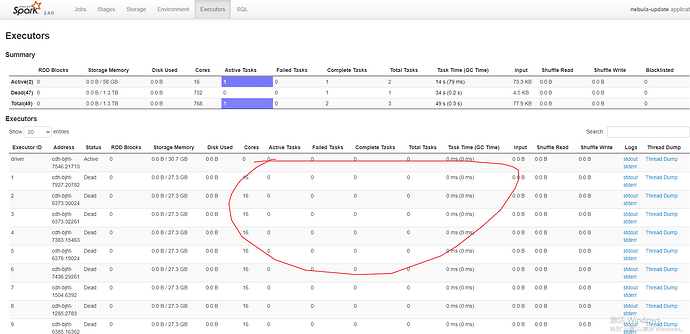

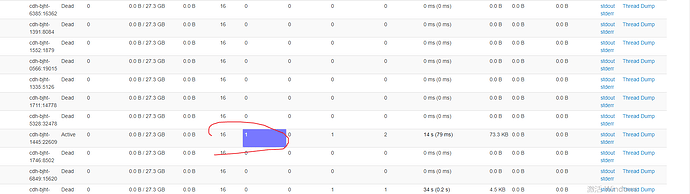

用connector update 数据 时 用spark sql select a,b,c from xxx 获取数据后怎样设置spark 分区 让其并多分区发执行,现在看日志只有一个Executors 执行

方法我已经找到了。 val df = spark.sql(selectSql).repartition(100) ,用repartition(100) 重新分区即可

1 个赞