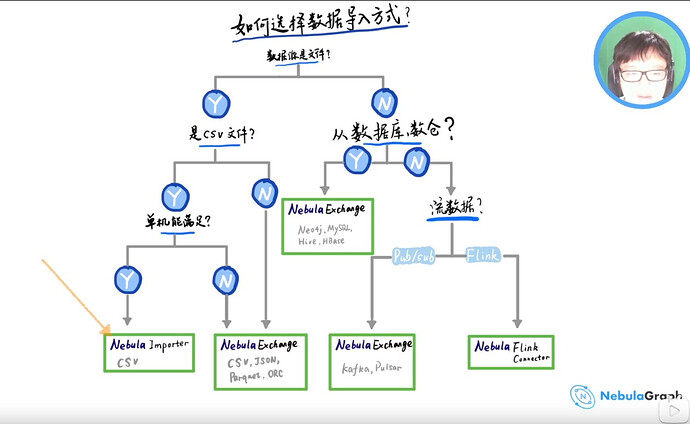

importer和exchange有什么区别么?

可以看下之前我们布道师 wey 的视频讲解: https://www.bilibili.com/video/BV1nh41167kj

个人理解就是 importer 适合轻量级的数据导入,如果你数据量大的话,可以用 nebula-exchange

我数据量有一亿到五十亿,用这个exchange工具选的是对的,但是问题是现在导入2千万就报错了,没导入成功

亿级的数据其实不大啊。用 importer 还是可以很稳妥的。回到你的问题来, 你的数据里面是不是有脏数据,导致数据导入不进来。

你的数据里面是不是有脏数据,导致数据导入不进来。

没有脏数据,我是用navicat统一带出csv格式文件的

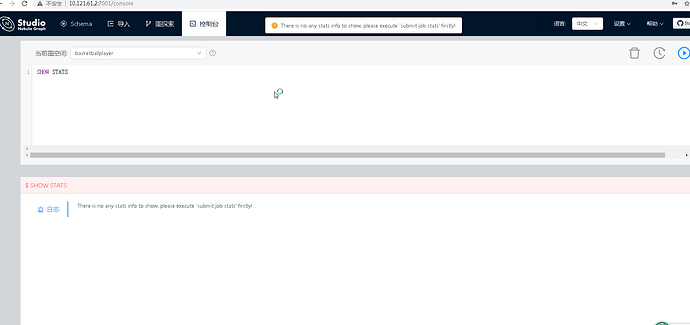

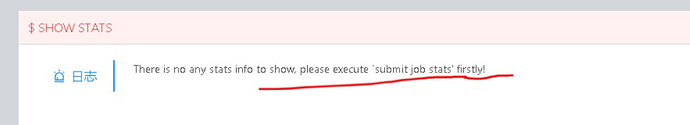

顺便问下,数据量大了后,单个tag统计总数,用 LOOKUP ON ceshi | YIELD COUNT(1) AS Follow_Number;比较慢,有快一些的统计方式么?

如果你只是统计数据的话,你可以用 SHOW STATS 来做数据统计就好啦,参考文档 https://docs.nebula-graph.com.cn/3.0.0/3.ngql-guide/7.general-query-statements/6.show/14.show-stats/ 这个是从 v2.0.0 开始支持的功能。

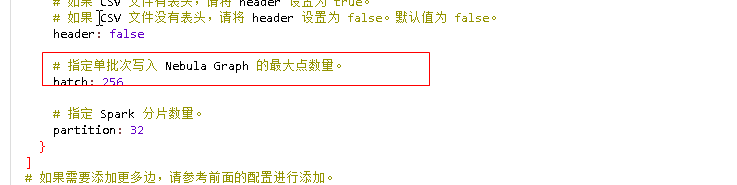

一般来说就是这个,batchsize 大点是会导入也快的,不过看你的机器环境,大概会有个临界值,超过这个数值之后速度会变慢。

已经解决了

batch size 设置256 没问题 你要是担心256设置的太大 小一点也可以 就是导入速度稍微慢一点

看报错直接原因就是 graphD 上的 metaclient 访问 meta 超时了,不知道 show hosts meta 看 meta 健康度如何?网络延迟大么?还是说写入的时候会造成 GraphD–MetaD 之间的网络瓶颈,增加延迟。

问下,10亿边数据,2台机器,一台500G内存,够导入的么,早上150G内存空间不够导入的

边数据总共10亿7千万,就一个属性,用exchange导入的,现在500G已经用了20G了,感觉内存空间不够了,数据才导入几千万

磁盘空间多大, 如果内存用的比较快的话,试试降低的你的 batchsize,虽然慢点,但可以导入。

如果内存用的比较快的话,试试降低的你的 batchsize,虽然慢点,但可以导入。