steam

21

我理解是可以,这块需要一个域名到 ip 的映射解析,我记得 v2.6.2 版本是支持的 cc @wey 我没记错对吧。

我理解是不需要的,你在哪台机器用 exchange 那台装上就好了,剩下就是 Nebula 集群的内部数据同步问题了。

如果是符合格式的数据,应该直接 ingest 导入就好了 https://docs.nebula-graph.com.cn/2.6.2/nebula-exchange/use-exchange/ex-ug-import-from-sst/#5_sst (第三步)

wey

22

之前确实有域名解析的问题,但是那个是 meta 地址,2.6 最后一个小版本修复支持了,HDFS 地址我不记得有不支持域名的问题哈

1 个赞

wey

23

可以的,手动按照特定的路径放到所有storaged 就可以,我之前的一个文章里是这么做的 https://www.siwei.io/nebula-exchange-sst-2.x/

wey

24

看起来您的 path 写的有点问题,local, remote 不用写 schema hdfs:// 部分,下边是我文章里的配置例子

path:{

local:"/tmp"

remote:"/sst"

hdfs.namenode: "hdfs://192.168.8.128:9000"

}

wey

26

这个 meta 地址应该是 docker/k8s 暴露出来的外部地址,从配置截图看,也可能是正确的(如果对应内部 xxx:9559),不过,exchange 会去通过 meta 拿到配置了的 storaged 的地址,请注意,storaged地址也需要在 spark 里边可以访问。

详见 https://www.siwei.io/nebula-algo-spark-k8s/

wey

28

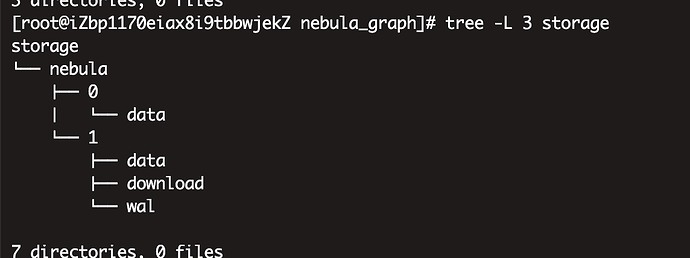

看你的 tree 应该是对的,如果space id 是 1 的话

download 里边的层级好像我写的 cp 命令有问题,可以参考这一楼

我们是部署在实体机子上 不是docker的方式的;

执行NGEST这个命令,是从那个目录加载sst数据?

这个目录,尝试过,但未加载成功

wey

30

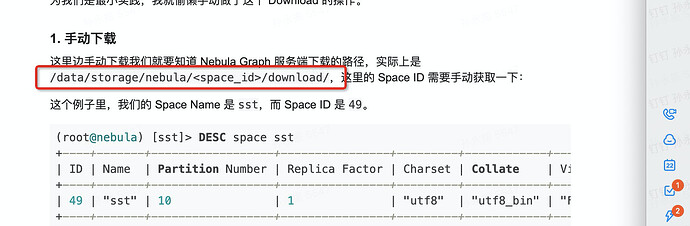

嗯嗯,容器里 /data/storage 应该对应 裸机默认的 /usr/local/nebula/data/storage/

到 download 一级之后,内部文件的层级对么?比如是不是多套了一层? 我手上暂时没有环境,不过你结合我贴那个评论应该能推出来对的情况,或者两种都试一下

system

关闭

31

此话题已在最后回复的 7 天后被自动关闭。不再允许新回复。