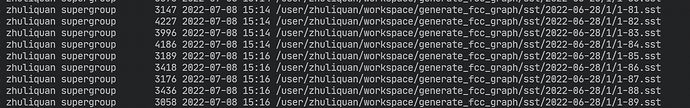

我跑数据设置batch 是 1024 partition 是 10个,有什么办法可以让sst 文件大一点,因为小文件上传会特别费时,同时还会导致大量时间都在上传文件,整体效率非常慢。跑一个只有1万个节点的数据,就需要用30多分钟。

使用repartitionWithNebula这个配置,生成的sst文件数=nebula space part数

1 个赞

我看了一下源码,那个repartition 设置为 图空间的parition 数,这个是为啥呢?

可以设置为 图空间 partition 的整数倍吗?

if (tagConfig.repartitionWithNebula) {

sstKeyValueData = customRepartition(spark, sstKeyValueData, partitionNum)

}

因为这样可以确保nebula一个partition的sst数据只落在一个sst文件中,这样就能保证不同的sst之间不存在key的overlap, 在将sst文件ingest到底层rocksdb存储中时,sst文件将直接落在LSM的L6层。(前提是数据库为空)

2 个赞

此话题已在最后回复的 30 天后被自动关闭。不再允许新回复。