nebula 版本:v2.6.2

部署方式:分布式 (3节点)

安装方式:RPM

是否为线上版本:N

硬件信息

磁盘: HHD+SSD 500G

CPU、内存信息: 48C / 180G

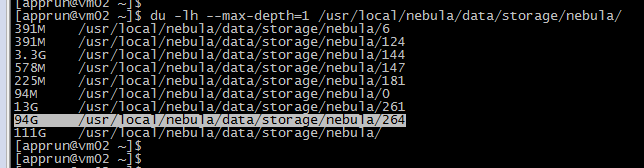

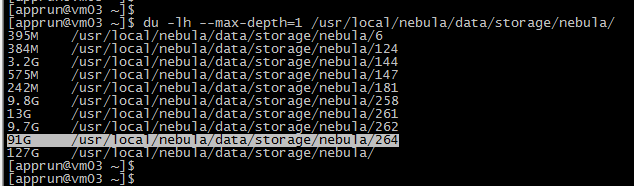

问题的具体描述:老师们好,请教一个exchange问题哈,使用exchange导入数据的时候,同一个space同一份数据多次导入不是覆盖插入吗?为什么我上面操作的时候是增量插入的呢?(一份数据30G,导入了3次,集群中每个节点的数据量变成了30*3=90G)

Nebula Exchange v2.6.3版本

Spark v2.4.0版本

CDH v6.3.2版本

wey

2

更新是逻辑上更新,在物理上数据是写在 LSM Tree 里的哈,所有的数据操作(增,删,改)都是 append。需要 compaction 才会合并数据。

可以了解一下这个机制哈,比如这个文章。

spw

3

1 个赞

谢谢古老师,这个文章讲的很详细。

再请问下,nebula数据库默认是自动Compaction,为啥导入之后还需要手动去 compaction 呢?

system

关闭

5

此话题已在最后回复的 7 天后被自动关闭。不再允许新回复。