- nebula 版本:2.5.0(Operator版本: 0.8.0)

- 部署方式:分布式

- 安装方式:helm和kubectl

- 是否为线上版本:Y

- 问题的具体描述

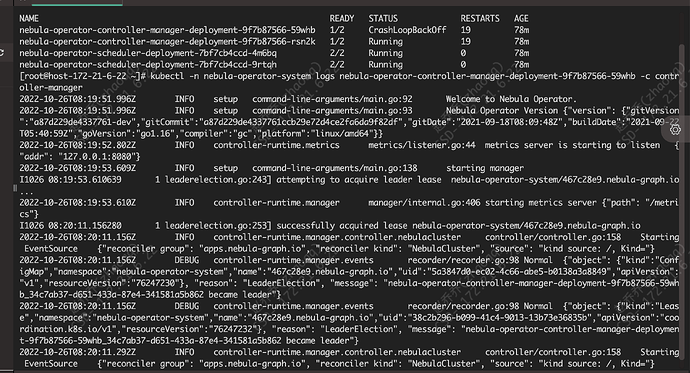

helm安装Nebula Operator后,operator-controller的状态为running,过了十分钟后状态变为CrashLoopBackOff,查看日志发现报错信息为

error: a container name must be specified for pod nebula-operator-controller-manager-deployment-9f7b87566-59whb, choose one of: [controller-manager kube-rbac-proxy],请问这是怎么回事?

kubectl -n nebula-operator-system logs nebula-operator-controller-manager-deployment-9f7b87566-59whb -c controller-manager

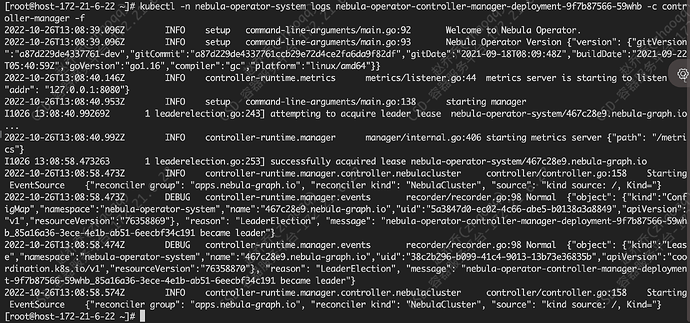

看这日志没有截取完整,使用命令跟踪下kubectl -n nebula-operator-system logs nebula-operator-controller-manager-deployment-9f7b87566-59whb -c controller-manager -f

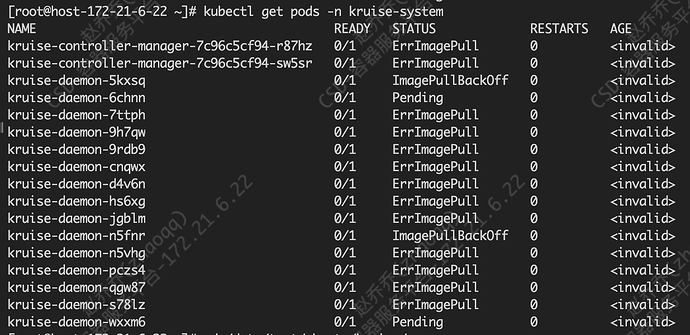

请问安装kruise的版本与k8s的版本有匹配的要求吗?我安装kruise总是不对。

版本有匹配要求,你这使用的nebula可以使用新版本吗,对应的operator也有启动配置优化

我有点奇怪的是,我在安装operator的时候manager两个pod的状态一直在running和CrashLoopBackOff之间跳跃,所以我查看了一下kruise的状态,发现都是拉取镜像失败的状态,那我为什么能安装operator呢?

还有我在安装kruise是应该与operator无关,我想请问一下如何离线安装kruise

operator启动时会发现kruise的相关crd,后来到1.0版本给优化成可配置了

可以下载kruise的helm charts安装,不用在线安装的方式

安装kruise对helm版本有要求吗?3.4+能安装成功吗?我一直失败是因为版本的原因吗?

3.4+可以的,看你这错误是镜像拉取失败了

嗯,是镜像拉取失败了,我是离线安装的,我把kruise-manager镜像都放到私库里面了,能直接docker pull 拉取kruise-manager并且我的operator也是这样安装的,镜像拉取成功状态也正常了:

。我看日志也没有有用信息,我想请问一下您之前遇到过这种情况吗?应该怎么解决呢?

现在还是nebula-operator启动失败吗

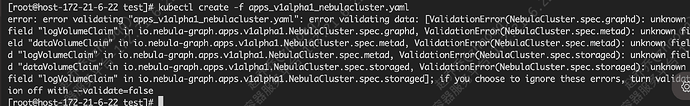

貌似状态稳定了,但我的kruise没安装成功,它怎么就稳定了呢?现在安装2.5.0版本的nebula也有报错,我用的是kubectl yaml的方式安装的,现在遇到报错

目前尚未建存储卷。但我不是很熟建存储卷也在尝试阶段。

看错误是operator版本升级后引起的,2.5.0可以使用operator 0.9.0,0.9.0优化了对kruise的启动依赖

我现在无法正确安装kruise,如果用operator0.9.0也无法安装operator了是吗?

请教一下这个问题,我现在执行kubectl create -f apps_v1alpha1_nebulacluster.yaml成功了,但是查看集群状态都没有启用,这个应该怎么查看呢?

0.9可以不用依赖kruise