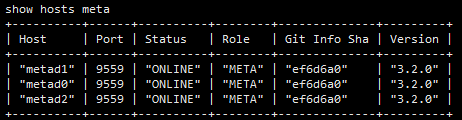

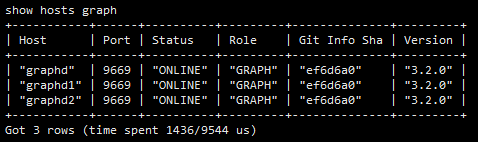

- nebula 版本:3.2.0

- 部署方式:云端

- 安装方式:Docker

- 是否为线上版本:Y

- 阿里云自己用docker搭建的测试机

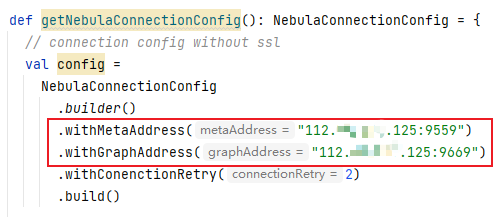

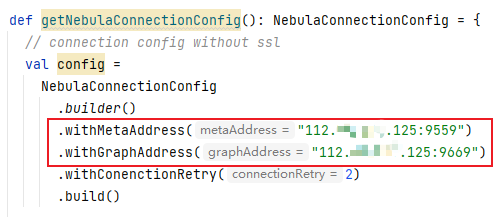

使用spark-writer 连接nebula连接失败connect time out

使用spark-writer 连接nebula连接失败connect time out

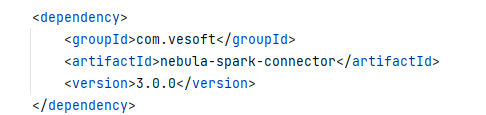

spark-connector版本为3.0.0

可以参考一下 https://siwei.io/nebula-algo-spark-k8s/

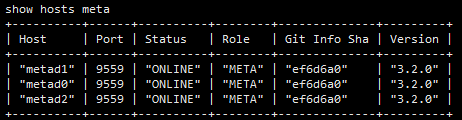

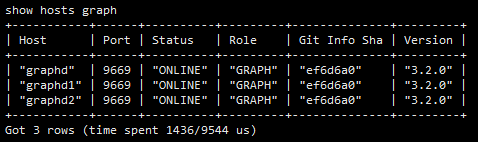

spark connector 读取数据是从meta 里获得 storaged 的地址,然后扫 storaged,你用 docker compose 部署的 nebula,这些地址都是容器间内部的域名,spark 如果不是在同一个容器网络是无法访问 metad storaged

docker compose 里最好的方法是 spark 运行在 nebula 同一个容器网络,你可以用 nebula-up 一键准备好这个环境用来开测试

http://nebula-up.siwei.io/ 用里边的all-in-one 全家桶模式

如果你竟然是在生产中用docker-compose跑nebula,那么spark 应该是跑在外边的,可以参考我这个方法https://gist.github.com/wey-gu/950e4f4c673badae375e59007d80d372

此话题已在最后回复的 7 天后被自动关闭。不再允许新回复。