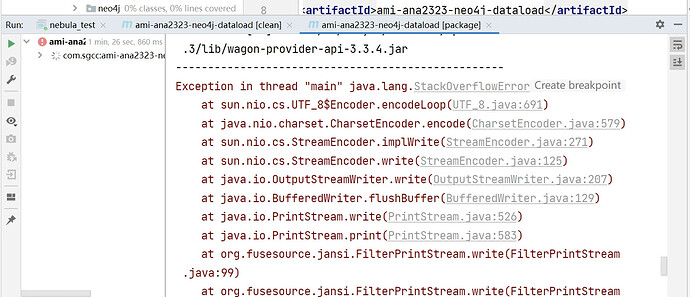

你好!我想问下昨天换了最新的的nebula-spark-connector3.4包,可是打包时却报stackflowerror的问题,而之前3.3.0的版本,我想问下3.4比3.3大了很多吗 为啥会报错啊

看你这个堆栈和connector没关系啊

之前3.3的时候好好的,换了3.4就报错了

你得看堆栈显示的问题啊,jvm 栈溢出,那就需要你调大jvm分配的栈size

得把堆内存改成4M,可是这样的大小上不了生产环境,内存溢出了,你们3.4.0是不是哪个程序写的超内存了啊 ![]()

- 你是在maven打包时栈溢出,还是在程序运行时。 如果是在打包时栈溢出,和程序运行没有任何关系,就算有内存泄漏之类的问题也不会在编译打包时触发

- 我使用默认的idea配置可以正常打包, github上的action也是没有额外配置栈大小

你可以看下你引入的依赖的量,以及引入依赖的方式

你意思是我引入其他依赖的量太多也会造成这个错误吗 引入依赖的方式就是pom文件导入

是呀,因为你是在maven package过程栈溢出了,pom 管理的依赖是一层层嵌入的,比如你引入的A,但A还引入了B,B引入了C,C引入了D 就要递归入栈的。 你可以在你引入的dependency中设置scope为provide,不引入该依赖内部的包

此话题已在最后回复的 30 天后被自动关闭。不再允许新回复。