- nebula 版本:3.4.0

- 部署方式:分布式

- 安装方式:Docker

- 是否上生产环境:Y

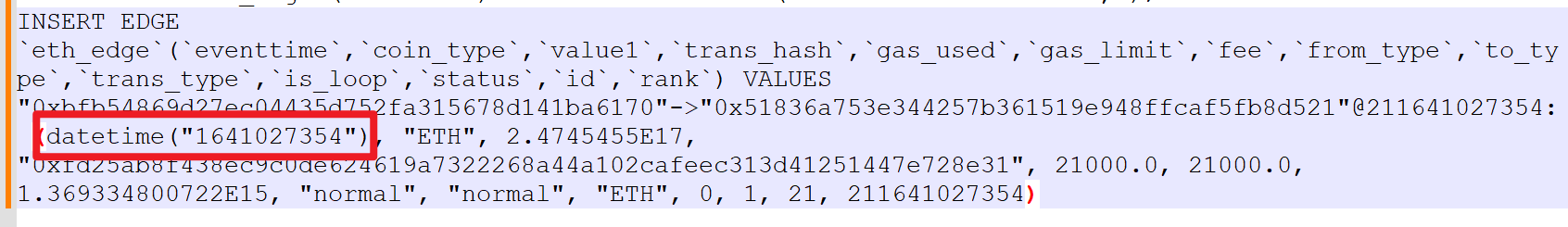

- spark-exchange导入orc文件时对于时间戳会识别成字符串,转成dateTime有错误,生成的语句如下:

spark-connector版本:nebula-exchange_spark_2.4-3.0.0.jar

orc文件用pyspark读取时类型是bigint

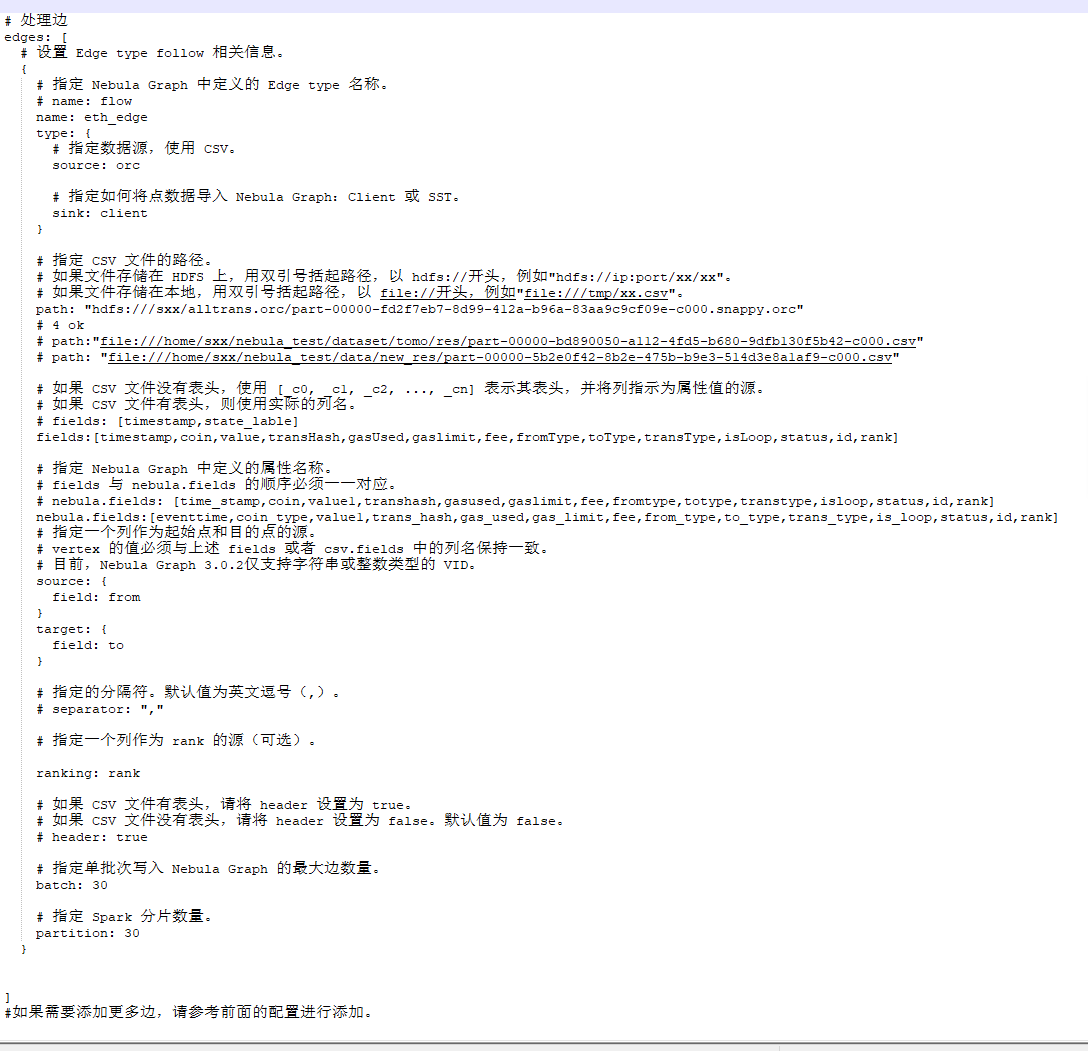

-conf文件

貌似不支持,timestamp作为输入,改成日期字符的输入就行了,已解决

1 个赞

可以勾选自己的回复为解决方案哈,我们的确不支持将数值类型直接转成 datetime。

此话题已在最后回复的 30 天后被自动关闭。不再允许新回复。