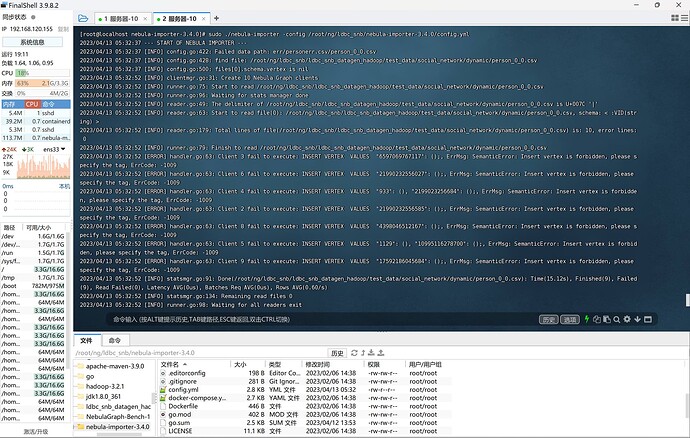

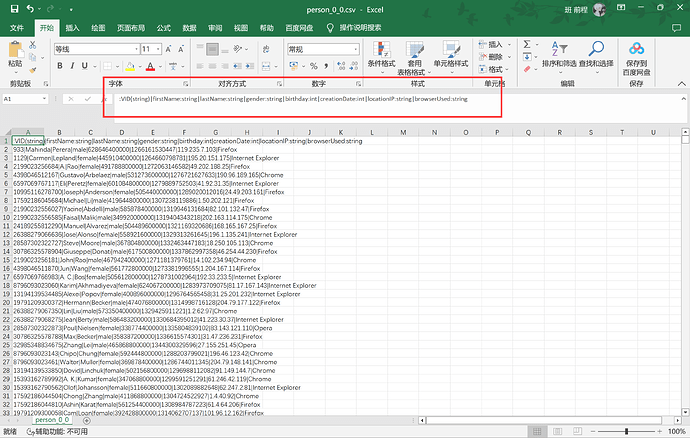

person_0_0.csv (125.9 KB)

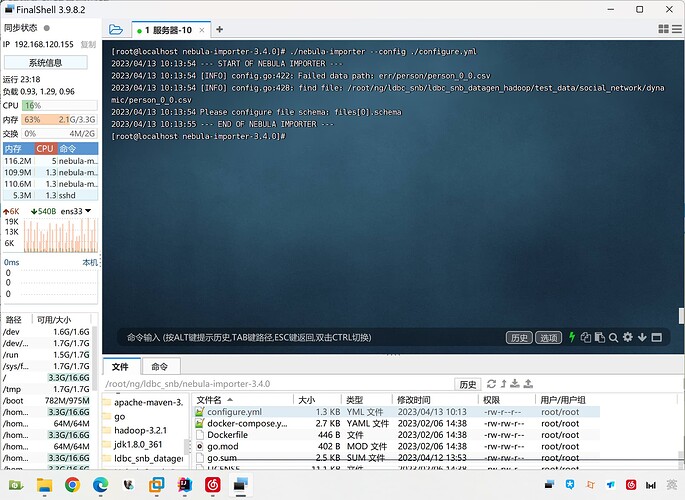

config.yml (2.8 KB)

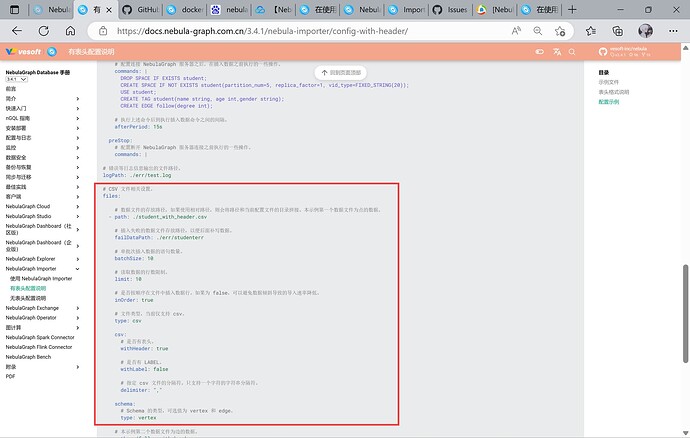

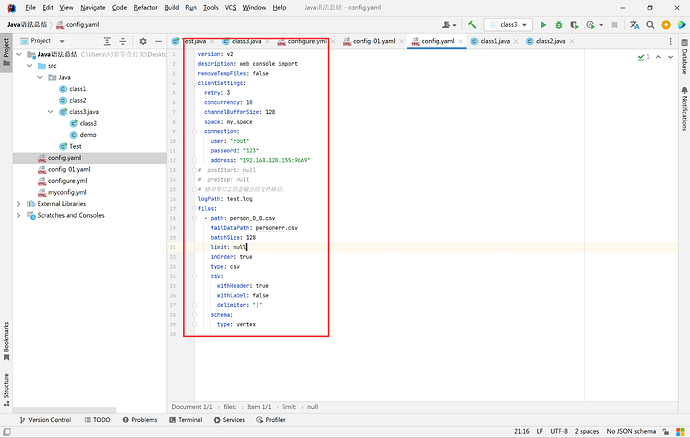

# 导入任务名称

name: myimporter

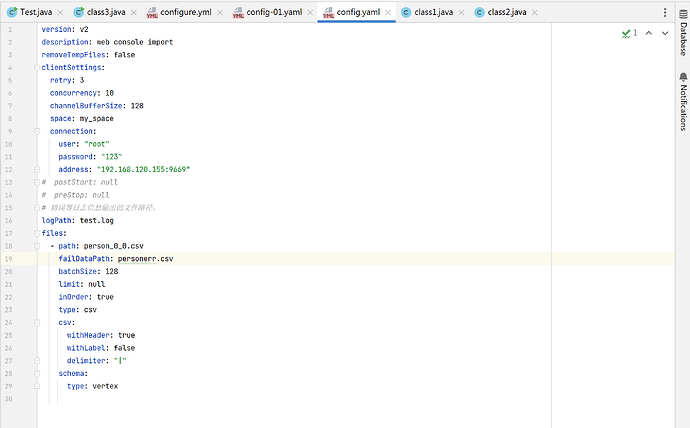

# 配置文件版本

version: v2

# 数据源配置

source:

type: csv

path: /root/ng/ldbc_snb/ldbc_snb_datagen_hadoop/test_data/social_network/dynamic/person_0_0.csv

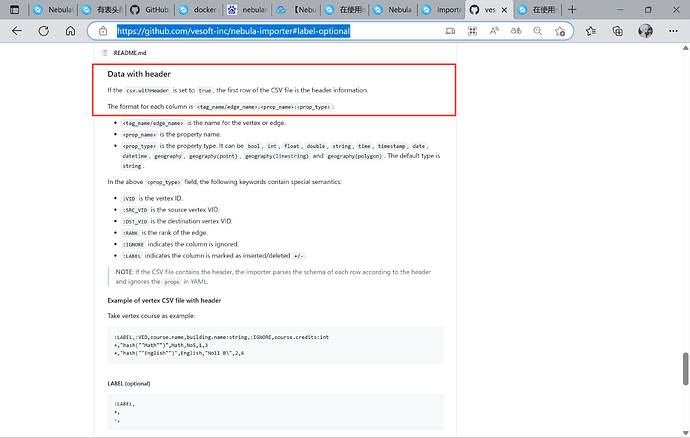

csv:

delimiter: "|"

header: true

schema:

id: string

firstName: string

lastName: string

gender: string

birthday: string

creationDate: string

locationIP: string

browserUsed: string

# Nebula Graph 目标数据库配置

sink:

# Nebula Graph 服务器的地址和端口号

# 如果 Nebula Graph 服务器运行在本地,可以将地址设置为 127.0.0.1

type: client

connection:

user: root

password: 123

address: ["127.0.0.1:9669"]

timeout: 3000

nebula:

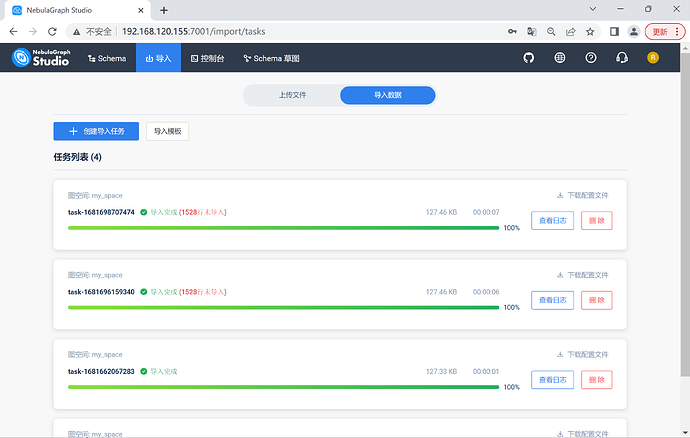

space: my_space

errorMax: 0

concurrency: 10

# 数据写入模式

# 如果数据已经存在,是否覆盖

# 如果覆盖,会删除已有的数据

# 如果不覆盖,会将新数据追加到已有数据的后面

#可选值为 "overwrite" 和 "append"

mode: overwrite

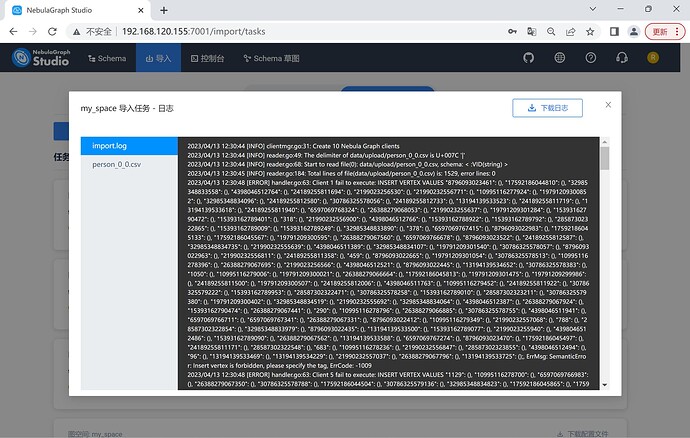

logPath: /root/ng/ldbc_snb/nebula-importer-3.4.0/file.log

removeTempFiles: true

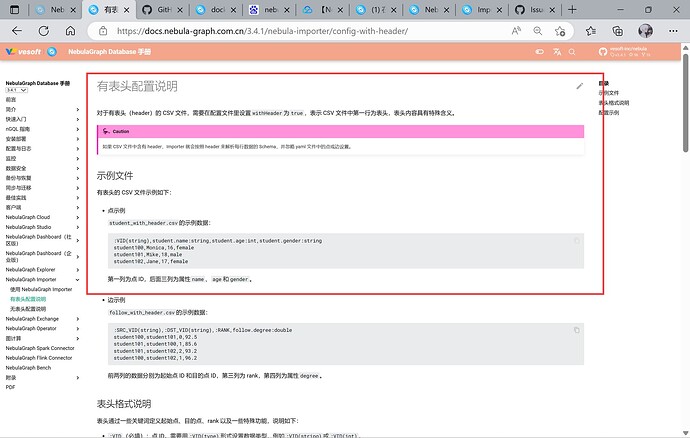

# Nebula Graph 中的标签和属性名称

# 用于将 CSV 文件中的列映射到 Nebula Graph 中的标签和属性

# 例如,下面的配置表示将 CSV 文件中的 "id" 列映射到 Nebula Graph 中的 "person" 标签的 "id" 属性

# 如果需要将多个列映射到多个标签和属性,可以添加多个映射规则

vertex:

fields:

- name: id

type: string

- name: firstName

type: string

- name: lastName

type: string

- name: gender

type: string

- name: birthday

type: string

- name: creationDate

type: string

- name: locationIP

type: string

- name: browserUsed

type: string

# Nebula Graph 客户端参数配置

clientSettings:

concurrency: 10

channelBufferSize: 128

connection:

user: root

password: 123

timeout: 3000000000