download hdfs:

手动上传目录并且执行ingest

用的哪个版本?

我在描述一下我的现象

1.配置好了hadoop_home以及java_home

2.download hdfs failed,转而尝试手动上传到data目录的download下面

3.手动ingest

nebula-graphd version 3.3.0, Git: c9f84b1, Build Time: Oct 25 2022 17:37:50

This source code is licensed under Apache 2.0 License.

要保证 storaged 的进程启动时候有这些变量,downlowd hdfs client call 是从 storaged 进程发起的

@nicole 这边 sst 导入之后数据查不出来(内核 3.3.0),可能和配置有关么?比如 repartitionWithNebula: False ?

在启动脚本指定了export HADOOP_HOME以及JAVA_HOME,大佬可以看一下我的第一张图

另外还有一个想象就是没有任何日志信息,只有一些端口被占用的waring,但是实际上进程正在running

{

# Spark config

spark: {

app: {

name: NebulaGraph_Exchange

}

}

# Nebula Graph config

nebula: {

address:{

graph:["xx:9669"]

meta:["xx:9559"]

}

user: root

pswd: nebula

space: test

path:{

# any path that owns read and write access is ok

local:"/tmp"

remote:"/tmp/xx"

hdfs.namenode: "hdfs://ha-nn-uri"

}

# nebula client connection parameters

connection {

timeout: 30000

}

error: {

max: 32

output: /tmp/errors

}

rate: {

limit: 1024

timeout: 3000

}

}

# Processing tags

tags: [

{

name: TestNode

type: {

source: hive

sink: sst

}

exec: "select src_vid vid from xx where src_vid='xx' union select dst_vid vid from xx where src_vid='xx'"

fields: []

nebula.fields: []

vertex: vid

batch: 2000

partition: 60

}

]

# process edges

edges: [

{

name: TestEdge

type: {

source: hive

sink: sst

}

exec: "select src_vid,dst_vid,edge_type,unix_timestamp(timestamp) ts,status from xx"

fields: [status]

nebula.fields: [status]

source: src_vid

target: dst_vid

ranking: ts

batch: 2000

partition: 60

}

]

}

可以先用 nebula sink,不用 sst ,验证/保证一下 hive source 这些都是ok的么?

确认了是ok的,因为看不到日志,不知道storaged发生了啥

无关

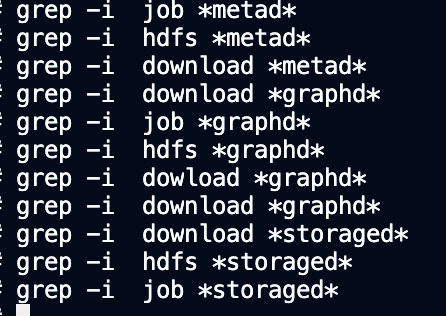

@心之所向 download失败原因可能有几点:

ingest后没有数据,你的exchange版本是多少?你的源数据中src_vid 和dst_vid是几个字符?

ps:

此话题已在最后回复的 30 天后被自动关闭。不再允许新回复。