1,k8s,以rke方式成功部署。

2,按照官网流程与示例,helm方式安装了operator.

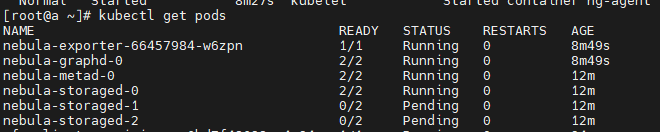

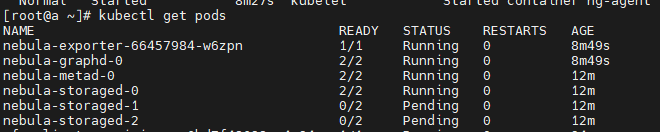

3,按照官网流程与示例,kubectl方式不是nebulaGraph出现如下情况:

storaged 有两个实例处于pending状态,怎么回事尼?

4,执行 kubectl describe pod nebula-storaged-1 ,显示:

另外:

k8s三台虚拟机环境节点,master,worker,etcd 各一个节点。

1,k8s,以rke方式成功部署。

2,按照官网流程与示例,helm方式安装了operator.

3,按照官网流程与示例,kubectl方式不是nebulaGraph出现如下情况:

storaged 有两个实例处于pending状态,怎么回事尼?

4,执行 kubectl describe pod nebula-storaged-1 ,显示:

另外:

k8s三台虚拟机环境节点,master,worker,etcd 各一个节点。

待调度节点打了taint标签导致nebula pod无法被调度,默认的调度策略是均匀分布的,你可以删除掉所有taint,或者更改下nebulacluster的spec,让所有storage pod调度到同一个node

1,通过查看节点污点发现集群默认给我创建了如下两个污点

[root@a ~]# kubectl get no -o yaml | grep taint -A 5

taints:

- effect: NoSchedule

key: node-role.kubernetes.io/controlplane

value: "true"

status:

addresses:

--

taints:

- effect: NoSchedule

key: node-role.kubernetes.io/etcd

value: "true"

status:

addresses:

2,执行以下命令进入nebula集群的编辑页面。

kubectl edit nebulaclusters.apps.nebula-graph.io nebula

3,再storage节点下 添加容忍

storaged:

tolerations:

- effect: NoSchedule

key: node-role.kubernetes.io/controlplane

operator: Equal

value: "true"

- effect: NoSchedule

key: node-role.kubernetes.io/etcd

operator: Equal

value: "true"

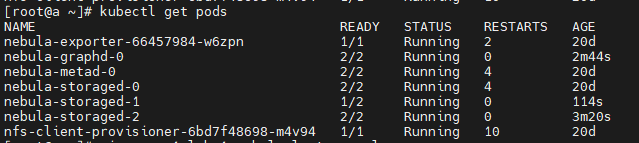

3,重启pod,所有节点running中

此话题已在最后回复的 7 天后被自动关闭。不再允许新回复。