一、引言

从业务需求角度看,许多互联网公司将其用于推荐系统、内容推荐以及用户画像等关键场景。这些场景往往需要处理海量的数据关系并进行实时分析。例如在推荐系统中,要快速分析用户的各种关联数据以提供精准推荐。如果性能不佳,就无法及时响应用户请求,导致推荐延迟,严重影响用户体验,进而可能造成用户流失。

在处理大规模数据方面,Nebula Graph通过数据分片来水平扩展和负载均衡。但随着数据规模的持续增长,性能优化变得更为关键。只有优化性能,才能确保在处理数以百万计的节点和边时系统稳定运行,避免因数据处理缓慢造成的系统卡顿。

从技术发展趋势来看,随着数据关系越来越复杂,查询需求也越来越多样化。Nebula Graph需要不断提升性能才能适应如多跳查询、子图查询等复杂操作的需求,跟上技术发展的步伐并在图数据库领域保持竞争力。总之,性能优化是Nebula Graph在现代数据处理中不可或缺的关键环节。

本大纲起到一个抛砖引玉的作用,每一章节一条展开来可能都是一个值得研究的性能优化方向,性能优化的路是漫长的,本文简单阐述作者在开发和使用nebula graph历程各个自认为性能优化需要的一些方向,聚合成此大纲以供参考。

二、性能分析

性能分析是发现问题和挖掘潜力的关键手段。就如同医生为病人做全面的身体检查,通过性能分析能够准确了解数据库在各种工作负载下的运行状况。它可以精确地指出哪些查询操作耗费了过多的资源,是 CPU 使用率过高,还是内存占用不合理,亦或是磁盘 I/O 瓶颈导致了性能的下降。

性能指标收集方法

- 使用Nebula Dashboard :Nebula Dashboard是一个可视化工具,提供了集群管理、监控、告警等功能。通过Nebula Dashboard,用户可以直观地查看各个节点的机器信息和Nebula Graph服务信息,分析并监控所选时间段的服务情况

- 慢查询日志 :通过分析慢查询日志,可以识别出执行缓慢的查询,从而进行针对性的优化。Nebula Graph提供了慢查询日志的收集和展示工具,帮助用户定位性能瓶颈。

- 自定义监控脚本 :基于Nebula Graph提供的性能数据接口,可以编写自定义的监控脚本来收集特定的性能指标。例如,可以使用Python编写脚本,定期请求Nebula Graph的性能数据接口,并将数据存储到数据库中进行分析

- 性能测试工具 :使用性能测试工具(如k6)进行压力测试,可以模拟高并发场景下的数据库性能表现。通过性能测试工具,可以收集到吞吐量、响应时间等关键性能指标

- 系统监控工具 :结合系统监控工具(如Prometheus、Grafana)来监控Nebula Graph集群的硬件资源使用情况,包括CPU、内存、磁盘I/O和网络带宽等

通过上述方法,可以全面收集Nebula Graph图数据库的性能指标,为性能优化提供数据支持。

图数据库性能瓶颈分析

在图数据库中,性能瓶颈可能出现在多个层面,包括数据模型设计、查询优化、硬件资源管理等。以下是对这些瓶颈的深入分析:

性能瓶颈分析

- 数据模型设计 :不合理的图数据模型设计可能导致查询效率低下。例如,过度复杂的节点和边关系会增加查询的复杂度,导致性能下降。

- 查询优化 :查询语句的优化对于提升图数据库性能至关重要。使用合适的索引、避免不必要的路径搜索等策略可以显著提高查询效率。

- 硬件资源管理 :硬件资源的不足,如CPU、内存、磁盘I/O等,都可能成为性能瓶颈。监控这些资源的使用情况,及时发现并解决资源瓶颈,对于保持图数据库的高效运行至关重要。

性能优化策略

- 索引优化 :合理设计索引结构,减少查询过程中的搜索范围,提高查询效率。

- 查询优化 :优化查询语句,减少不必要的计算和数据传输。

- 硬件资源升级 :根据性能监控结果,适时升级硬件资源,如增加内存、使用更快的存储设备等。

- 分布式架构 :对于大规模图数据,采用分布式架构可以有效分散负载,提高系统的并发处理能力。

通过上述分析和策略,可以有效地识别和解决图数据库中的性能瓶颈,提升系统的整体性能和稳定性。

三、Profile分析

Nebula Graph的Profile命令使用

在Nebula Graph中,PROFILE命令用于分析查询的执行计划和性能,帮助开发者识别和优化查询性能瓶颈。以下是一些使用PROFILE命令的案例和优化示例:

案例:基本查询分析

假设我们有一个查询,想要找到名为"Tim Duncan"的球员及其关注的人:

GO FROM "player100" OVER follow YIELD follow._dst AS dst, properties($).name AS name;

使用PROFILE命令分析这个查询:

PROFILE GO FROM "player100" OVER follow YIELD follow._dst AS dst, properties($).name AS name;

这将返回查询的执行计划,包括每个算子的执行时间、数据传输量等详细信息。除了profile语句外还有类似的explain语句。

EXPLAIN语句输出 nGQL 语句的执行计划,但不会执行 nGQL 语句。

PROFILE语句执行 nGQL 语句,然后输出执行计划和执行概要。用户可以根据执行计划和执行概要优化查询性能。

执行计划器将解析后的 nGQL 语句处理为action。action是最小的执行单元。典型的action包括获取指定点的所有邻居、获取边的属性、根据条件过滤点或边等。每个action都被分配给一个operator。

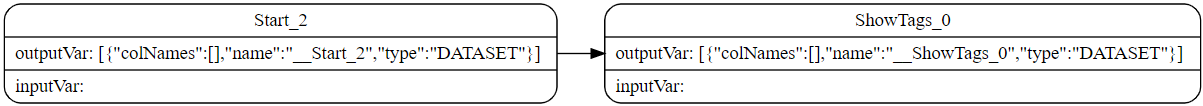

例如SHOW TAGS语句分为两个action,operator为Start和ShowTags。更复杂的GO语句可能会被处理成 10 个以上的action。

- EXPLAIN语句

EXPLAIN [format="row" | "dot"] <your_nGQL_statement>;

- PROFILE语句

PROFILE [format="row" | "dot"] <your_nGQL_statement>;

profile输出格式

EXPLAIN或PROFILE语句的输出有两种格式:row(默认)和dot。用户可以使用format选项修改输出格式。

row格式Graph

row格式将返回信息输出到一个表格中。

EXPLAIN

nebula> EXPLAIN format="row" SHOW TAGS;

Execution succeeded (time spent 327/892 us)

Execution Plan

-----+----------+--------------+----------------+----------------------------------------------------------------------

| id | name | dependencies | profiling data | operator info |

-----+----------+--------------+----------------+----------------------------------------------------------------------

| 1 | ShowTags | 0 | | outputVar: [{"colNames":[],"name":"__ShowTags_1","type":"DATASET"}] |

| | | | | inputVar: |

-----+----------+--------------+----------------+----------------------------------------------------------------------

| 0 | Start | | | outputVar: [{"colNames":[],"name":"__Start_0","type":"DATASET"}] |

-----+----------+--------------+----------------+----------------------------------------------------------------------

PROFILE

nebula> PROFILE format="row" SHOW TAGS;

+--------+

| Name |

+--------+

| player |

| team |

+--------+

Got 2 rows (time spent 2038/2728 us)

Execution Plan

-----+----------+--------------+----------------------------------------------------+----------------------------------------------------------------------

| id | name | dependencies | profiling data | operator info |

-----+----------+--------------+----------------------------------------------------+----------------------------------------------------------------------

| 1 | ShowTags | 0 | ver: 0, rows: 1, execTime: 42us, totalTime: 1177us | outputVar: [{"colNames":[],"name":"__ShowTags_1","type":"DATASET"}] |

| | | | | inputVar: |

-----+----------+--------------+----------------------------------------------------+----------------------------------------------------------------------

| 0 | Start | | ver: 0, rows: 0, execTime: 1us, totalTime: 57us | outputVar: [{"colNames":[],"name":"__Start_0","type":"DATASET"}] |

-----+----------+--------------+----------------------------------------------------+----------------------------------------------------------------------

| 参数 | 说明 |

|---|---|

id |

operator的 ID。 |

name |

operator的名称。 |

dependencies |

当前operator所依赖的operator的 ID。 |

profiling data |

执行概要文件内容。 ver表示operator的版本;rows表示operator输出结果的行数;execTime表示执行action的时间;totalTime表示执行action的时间、系统调度时间、排队时间的总和。 |

operator info |

operator的详细信息。 |

dot格式Graph

dot格式将返回 DOT 语言的信息,然后用户可以使用 Graphviz 生成计划图。

Note

Graphviz 是一款开源可视化图工具,可以绘制 DOT 语言脚本描述的图。Graphviz 提供一个在线工具,可以预览 DOT 语言文件,并将它们导出为 SVG 或 JSON 等其他格式。详情请参见 Graph。

nebula> EXPLAIN format="dot" SHOW TAGS;

Execution succeeded (time spent 161/665 us)

Execution Plan

--------------------------------------------------------------------------------------------------------------------------------------------- -------------

plan

--------------------------------------------------------------------------------------------------------------------------------------------- -------------

digraph exec_plan {

rankdir=LR;

"ShowTags_0"[label="ShowTags_0|outputVar: \[\{\"colNames\":\[\],\"name\":\"__ShowTags_0\",\"type\":\"DATASET\"\}\]\l|inputVar:\l", shape=Mrecord];

"Start_2"->"ShowTags_0";

"Start_2"[label="Start_2|outputVar: \[\{\"colNames\":\[\],\"name\":\"__Start_2\",\"type\":\"DATASET\"\}\]\l|inputVar: \l", shape=Mrecord];

}

--------------------------------------------------------------------------------------------------------------------------------------------- -------------

将上述示例的 DOT 语言转换为 Graphviz 图,如下所示。

通过上述示例和分析,可以更好地理解如何分析Nebula Graph中的PROFILE命令结果,并进行相应的优化。

profile相关详细信息参考官方文档:EXPLAIN和PROFILE - NebulaGraph Database 手册

四、压测脚本与工具

常用的图数据库压测工具

在Nebula Graph图数据库中,常用的压测工具包括k6 、Nebula Bench 和nebula-importer 。这些工具可以帮助开发者评估数据库在不同负载下的性能表现,从而进行针对性的优化。以下是这些工具的简要介绍:

- k6 :一个开源的负载测试工具,使用Go语言编写,能够模拟大量虚拟用户对Nebula Graph进行压力测试 。

- Nebula Bench :一个集成了数据生成、导入和压测的工具,支持使用LDBC SNB数据集进行性能测试 。

- nebula-importer :用于将数据导入Nebula Graph的工具,通常与Nebula Bench结合使用,以便在压测前准备测试数据。

自定义压测脚本的编写

使用Python编写压测脚本

首先,确保安装了thrift和nebula2-python库:

pip install thrift nebula2-python

以下是一个简单的Python压测脚本示例:

import time

from concurrent.futures import ThreadPoolExecutor

from nebula2.graph import GraphClient

from nebula2.common.ttypes import *

def make_request(client, query, num_requests):

for _ in range(num_requests):

start_time = time.time()

try:

client.execute(query)

except Exception as e:

print(f"Request failed: {e}")

end_time = time.time()

yield end_time - start_time

def main():

# 连接到Nebula Graph

client = GraphClient()

client.connect('127.0.0.1', 9669)

client.login('user', 'password')

query = 'GO FROM "node1" OVER edge1 YIELD edge1._dst AS dst'

num_requests = 100

num_threads = 10

with ThreadPoolExecutor(max_workers=num_threads) as executor:

futures = [executor.submit(lambda: list(make_request(client, query, 1))) for _ in range(num_requests)]

total_response_time = sum(sum(future.result()) for future in futures)

average_response_time = total_response_time / (num_requests * num_threads)

print(f"Average response time: {average_response_time} seconds")

client.release()

if __name__ == "__main__":

main()

使用Java编写压测脚本

首先,确保添加了Nebula Graph的Java SDK依赖到项目中。

以下是一个简单的Java压测脚本示例:

import com.vesoft.nebula.client.graph.GraphClient;

import com.vesoft.nebula.client.graph.data.Result;

import com.vesoft.nebula.client.graph.net.Session;

import java.util.concurrent.CountDownLatch;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class NebulaGraphStressTest {

private static final String HOST = "127.0.0.1";

private static final int PORT = 9669;

private static final String USER = "user";

private static final String PASSWORD = "password";

private static final String QUERY = "GO FROM \"node1\" OVER edge1 YIELD edge1._dst AS dst";

private static final int NUM_REQUESTS = 100;

private static final int NUM_THREADS = 10;

public static void main(String[] args) throws InterruptedException {

GraphClient client = GraphClient.getInstance(HOST, PORT);

Session session = client.connect(USER, PASSWORD);

ExecutorService executorService = Executors.newFixedThreadPool(NUM_THREADS);

CountDownLatch latch = new CountDownLatch(NUM_REQUESTS);

long startTime = System.currentTimeMillis();

for (int i = 0; i < NUM_REQUESTS; i++) {

executorService.submit(() -> {

try {

Result result = session.execute(QUERY);

// 处理结果(如果需要)

} catch (Exception e) {

e.printStackTrace();

} finally {

latch.countDown();

}

});

}

latch.await();

long endTime = System.currentTimeMillis();

double averageResponseTime = (endTime - startTime) / (double) NUM_REQUESTS / 1000;

System.out.println("Average response time: " + averageResponseTime + " seconds");

session.release();

client.release();

}

}

注意事项

- 认证信息 :确保使用正确的用户名和密码连接到Nebula Graph。

- 查询语句 :根据实际需求修改查询语句。

- 并发控制 :根据系统资源和需求调整线程数和请求数。

- 错误处理 :在实际应用中,需要更完善的错误处理机制。

使用C++编写压测脚本

以下是一个简单的C++压测脚本示例:

#include <thrift/transport/TSocket.h>

#include <thrift/transport/TTransportUtils.h>

#include <thrift.protocol/TBinaryProtocol.h>

#include <nebula/graph/GraphService.h>

#include <iostream>

#include <thread>

#include <vector>

using namespace apache::thrift;

using namespace apache::thrift::protocol;

using namespace apache::thrift::transport;

using namespace nebula::graph;

const std::string HOST = "127.0.0.1";

const int PORT = 9669;

const std::string USER = "user";

const std::string PASSWORD = "password";

const std::string QUERY = "GO FROM \"node1\" OVER edge1 YIELD edge1._dst AS dst";

const int NUM_REQUESTS = 100;

const int NUM_THREADS = 10;

void make_request(int num_requests) {

std::shared_ptr<TSocket> socket(new TSocket(HOST, PORT));

std::shared_ptr<TTransport> transport(new TBufferedTransport(socket));

std::shared_ptr<TProtocol> protocol(new TBinaryProtocol(transport));

GraphServiceClient client(protocol);

try {

transport->open();

client.login(USER, PASSWORD);

for (int i = 0; i < num_requests; ++i) {

client.execute(QUERY);

}

transport->close();

} catch (TException& tx) {

std::cerr << "Request failed: " << tx.what() << std::endl;

}

}

int main() {

std::vector<std::thread> threads;

auto start_time = std::chrono::high_resolution_clock::now();

for (int i = 0; i < NUM_REQUESTS; ++i) {

threads.emplace_back(make_request, 1);

}

for (auto& thread : threads) {

thread.join();

}

auto end_time = std::chrono::high_resolution_clock::now();

auto duration = std::chrono::duration_cast<std::chrono::milliseconds>(end_time - start_time).count();

double average_response_time = duration / static_cast<double>(NUM_REQUESTS) / 1000;

std::cout << "Average response time: " << average_response_time << " seconds" << std::endl;

return 0;

}

注意事项

- 依赖库 :确保安装了Thrift和Nebula Graph的C++ SDK。

- 编译链接 :正确配置编译器和链接器选项,以包含必要的库文件。

- 错误处理 :在实际应用中,需要更完善的错误处理机制。

这些示例脚本提供了基本的压测框架,可以根据具体需求进行扩展和优化,例如添加更多的查询类型、处理不同的响应结果、集成到自动化测试框架中等。

五、上层客户端优化

在Nebula Graph图数据库中,客户端优化对于提升系统整体性能。通过优化客户端与服务器之间的通信,减少不必要的数据传输和处理,可以显著提高系统的响应速度和处理能力。优化的客户端能够更高效地利用服务器资源,减少服务器的压力,从而降低服务器的运营成本。

查询语句优化技巧

1. 使用索引

- 创建索引 :为经常查询的节点属性和边类型创建索引,以加速查找过程。例如:

CREATE TAG INDEX player_name_index ON player(name);

CREATE EDGE INDEX follow_degree_index ON follow(degree);

- 复合索引 :对于多属性查询,创建复合索引可以显著提高查询效率。例如:

CREATE INDEX player_name_age_index ON player(name, age);

2. 优化查询模式

- 避免笛卡尔乘积 :在查询中尽量避免使用笛卡尔乘积操作,这会导致查询结果集急剧增大。可以通过预先计算和缓存结果来优化。

- 减少遍历节点和关系数量 :在MATCH和GO语句中,尽量减少遍历的节点和关系数量,使用更精确的过滤条件。例如:

MATCH (p:player)-[f:follow]->(foll:player) WHERE p.name == "Tim Duncan" AND foll.age > 30;

3. 使用缓存

- 结果缓存 :对于频繁执行的查询,可以考虑将结果缓存起来,减少数据库的负载。

4. 查询优化

- 使用EXPLAIN分析查询计划 :通过EXPLAIN命令分析查询计划,找出性能瓶颈并进行优化。例如:

EXPLAIN MATCH (p:player)-[f:follow]->(foll:player) WHERE p.name == "Tim Duncan" AND foll.age > 30;

- 避免不必要的属性返回 :在YIELD子句中,只返回必要的属性,减少数据传输量。例如:

GO 2 STEPS FROM "player102" OVER follow YIELD dst(edge);

5. 数据建模优化

- 合理设计节点和边 :确保节点和边的设计符合实际业务逻辑,避免过度复杂化。

- 减少数据膨胀 :避免冗余关系和节点,减少图的复杂度,从而提高查询效率。

6. 并发控制

- 控制并发请求数量 :避免过多的并发请求导致服务器过载,合理控制并发请求的数量。

连接池的设置

- 最大连接数 :根据系统资源和并发需求合理设置max_connection_pool_size,避免过多连接导致资源浪费或过少连接引发性能瓶颈。

- 空闲连接超时 :配置idle_connection_timeout,定期清理长时间未使用的连接,释放资源。

- 连接池初始化 :在应用启动时初始化连接池,确保连接池在需要时已准备好。

连接池的优化

- 负载均衡 :在多Graph服务部署时,连接池应采用轮询策略分配连接,实现负载均衡。

- 连接复用 :通过连接池复用连接,减少频繁创建和关闭连接的开销。

- 监控与调优 :实时监控连接池状态,根据监控数据调整连接池配置,如动态调整最大连接数。

Space和Session的关联优化

- Session管理 :每个Session应与特定的space关联,避免跨space操作导致资源竞争。

- 多线程Session复用 :在多线程环境下,为每个线程维护独立的Session,避免Session共享导致的线程安全问题。

- Session超时控制 :设置合理的session_idle_timeout,自动释放长时间未使用的Session,提高资源利用率。

六、中间Graph计算层优化

图计算层的工作原理

Nebula Graph的计算层是处理图查询的核心部分,它负责解析客户端发送的查询请求,生成执行计划,并通过优化策略提高查询效率。以下是Nebula Graph计算层的工作原理:

计算层的主要组件

- Parser :负责将客户端发送的nGQL文本解析成抽象语法树(AST),这是查询处理的第一步。

- Validator :对AST进行校验,确保查询语句的合法性,包括元数据信息的校验、上下文引用校验和类型推断校验。

- Planner :生成可执行计划,这是查询优化的关键步骤,包括选择合适的算子和确定执行顺序。

- Executor :执行由Planner生成的执行计划,通过调用存储层的接口获取数据,并返回查询结果。

计算层的优化策略

- 异步和并发执行 :采用异步及并发操作来处理IO和网络长时延操作,提高查询效率。

- 计算下沉 :将条件过滤等算子随查询条件一同下发到存储层节点,减少不必要的数据传输。

- 执行计划优化 :包括执行计划缓存和上下文无关语句的并发执行,以提高查询性能。

计算层与存储层的交互

计算层通过RPC(远程过程调用)与存储层进行交互,主要接口包括getNeighbors和getProps,用于获取节点和边的属性信息。这种设计使得计算层能够高效地从存储层获取所需数据,同时减少网络传输的开销。

七、底层Storage存储层优化

存储层架构概述

Nebula Graph的存储层主要由三层组成:存储引擎层、共识层和存储接口层。存储引擎层负责数据的实际存储,共识层确保数据的一致性和高可用性,而存储接口层则提供对外的RPC接口,供计算层调用。

存储引擎层

存储引擎层使用RocksDB作为其核心存储引擎,负责数据的读写操作。RocksDB是一个高性能的嵌入式键值存储库,适用于需要快速读写大量数据的场景。

共识层

共识层实现了Raft一致性协议,确保数据在多个副本之间保持一致。Raft协议通过选举领导者(Leader)来管理日志复制,从而保证数据的一致性和高可用性。

存储接口层

存储接口层定义了一系列与图相关的API,这些API请求会被翻译成一组针对相应分片的键值操作。这一层的设计使得存储服务能够处理复杂的图查询,而不仅仅是简单的键值对操作。

数据分布优化

- 数据分片 :Nebula Graph使用分布式架构,通过数据分片将图数据分布到多个节点上,以实现数据的水平扩展和负载均衡。合理设计分片策略,确保数据均匀分布,避免单个节点过载。

- 负载均衡 :在多Graph服务部署时,采用轮询策略分配连接,实现负载均衡,避免资源浪费和性能瓶颈。

索引优化

- 创建索引 :为space中的节点和边属性创建索引,加速纯属性条件查询。选择合适的索引类型,如标签索引和边索引,根据具体需求进行优化。

- 索引维护 :定期检查索引的使用情况,删除不再使用的索引,减少存储和查询开销。利用Nebula Graph提供的工具监控索引性能,及时调整索引策略。

数据压缩

Nebula Graph 使用 RocksDB 作为其底层存储引擎,RocksDB 本身就提供了多种压缩算法来减少存储空间的使用。这些压缩算法包括 Snappy、Zlib、LZ4 和 ZSTD 等,它们可以在不同的压缩比和性能之间进行权衡。用户可以根据实际需求选择合适的压缩算法。

序列化

Nebula Graph 使用 Protocol Buffers(简称 Protobuf)作为其序列化框架。Protobuf 是一种语言中立、平台中立、可扩展的序列化结构数据的方法,它能够高效地将数据结构转换为二进制格式,便于存储和网络传输。在 Nebula Graph 中,序列化主要用于以下几个方面:

- 点和边的存储 :Nebula Graph 将点和边的信息序列化为二进制格式,存储在 RocksDB 中。这种序列化方式不仅减少了存储空间的使用,还提高了数据的读取速度。

- 索引数据 :为了加速查询,Nebula Graph 为节点和边创建索引。这些索引数据同样需要序列化后存储在 RocksDB 中。

八、RocksDB参数调优

RocksDB是一个高性能、可扩展、嵌入式、持久化、可靠、易用和可定制的键值存储库。它采用LSM树数据结构,支持高吞吐量的写入和快速的范围查询,可被嵌入到应用程序中,实现持久化存储,支持水平扩展,可以在多台服务器上部署,实现集群化存储,具有高度的可靠性和稳定性,易于使用并可以根据需求进行定制和优化

RocksDB的关键参数

- Block Cache:用于缓存数据块的内存部分,可以显著提高读取性能。参数包括block_cache_size(缓存大小)和block_size(块大小)。

- Memtable:内存中的写缓冲区,参数包括write_buffer_size(写缓冲区大小)和max_write_buffer_number(最大写缓冲区数量)。

- Compaction:后台压缩操作,参数包括max_background_compactions(最大后台压缩线程数)和level_compaction_dynamic_level_bytes(启用动态层级压缩)。

- Compression:数据压缩类型,RocksDB支持多种压缩算法,如Snappy、LZ4、Zlib等,参数为compression_type。

- WAL (Write-Ahead Log):用于崩溃恢复的日志,参数包括wal_dir(WAL文件存储路径)和wal_ttl_seconds(WAL文件生存时间)。

- max_background_compactions:设置最大后台压缩线程数,默认为1,增加此值可加快压缩速度,但也会增加CPU和I/O负载。

- max_background_flushes:设置最大后台刷新线程数,默认为1,增加此值可加快数据从Memtable到磁盘的写入速度。

- max_open_files:设置RocksDB可以同时打开的最大文件数,默认为-1,表示不限制,但应根据系统资源和文件描述符限制进行调整。

- max_total_wal_size:设置WAL文件的最大总大小,超过此值将触发压缩操作,有助于控制WAL文件的大小和数量。

- min_write_buffer_number_to_merge:在刷新到Level 0之前,最少需要被合并的Memtable个数,默认为1,增加此值可减少写放大,但可能增加读放大。

- level0_file_num_compaction_trigger:当Level 0的SST文件数量达到此值时,触发压缩操作,默认为4,增加此值可减少Level 0的文件数量,但可能增加写放大。

- level0_slowdown_writes_trigger:当Level 0的SST文件数量达到此值时,降低写入速度,默认为10,增加此值可避免Level 0的文件过多,但可能影响写入性能。

- level0_stop_writes_trigger:当Level 0的SST文件数量达到此值时,停止写入操作,默认为15,增加此值可避免Level 0的文件过多,但可能影响写入性能

RocksDB参数调优策略

在Nebula Graph中,针对不同的性能需求(优先读或优先写),可以通过调整RocksDB的相关参数来优化性能。以下是针对优先读和优先写两种场景的一些建议配置参数和考虑因素,但请注意,实际配置可能需要根据具体的硬件环境、工作负载和数据特性进行调整。

优先读性能配置

当优先考虑读取性能时,目标是最大化缓存命中率和减少读取延迟。以下是一些关键参数和建议配置:

- Block Cache ( block_cache_size):

- 增加块缓存大小以容纳更多的数据块,从而提高缓存命中率。

- 配置公式:block_cache_size = 可用内存 * 0.7(假设保留30%的内存用于其他用途)

- Block Size ( block_size):

- 适当增大块大小可以减少元数据开销和读取次数,但也会增加单次读取的数据量。

- 配置公式:block_size = 64KB(常用值,可根据实际情况调整)

- Compression ( compression_type):

- 使用更快的压缩算法(如Snappy)以减少CPU使用率,从而间接提高读取性能。

- 配置建议:compression_type = “snappy”

- Bloom Filters ( bloom_filter_bits_per_key 和 bloom_filter_fpp):

- 启用布隆过滤器以快速判断键是否存在,减少不必要的磁盘读取。

- 配置建议:根据数据量和误报率需求调整参数。

优先写性能配置

当优先考虑写入性能时,目标是最大化写入吞吐量和减少写入延迟。以下是一些关键参数和建议配置:

- Write Buffer Size ( write_buffer_size 和 max_write_buffer_number):

- 增大写缓冲区大小以容纳更多的写入数据,从而减少磁盘I/O次数。

- 配置公式:

- write_buffer_size = 128MB(常用值,可根据实际情况调整)

- max_write_buffer_number = 4(默认值,可根据需要增加)

- Min Write Buffer Number To Merge ( min_write_buffer_number_to_merge):

- 调整此参数以控制合并操作的频率,从而平衡写入性能和存储空间利用率。

- 配置建议:min_write_buffer_number_to_merge = 2(默认值,可根据需要调整)

- Compression ( compression_type):

- 使用更快的压缩算法以减少CPU使用率,但可能会牺牲一些写入性能。

- 配置建议:compression_type = “snappy” 或根据需要选择其他算法

- Write-Ahead Log (WAL) 相关参数 :

- 调整WAL文件的大小和数量限制,以平衡写入性能和恢复能力。

- 配置建议:根据写入负载和恢复需求调整max_total_wal_size和wal_ttl_seconds等参数。

rocksdb的参数调优是一项根据自身业务和环境机器等各种因素相结合的长久事项,以上配置仅提供一些常见的参考,若在此有想深入了解可以多参考一些业界资料

[1] RocksDB 官方网站. https://rocksdb.org/

[2] Redis as State Backend. https://issues.apache.org/jira/browse/FLINK-3035

[3] RocksDB 基本概念. https://github.com/facebook/rocksdb/wiki/RocksDB-Basics

[4] Flink 配置参数列表. https://ci.apache.org/projects/flink/flink-docs-stable/ops/config.html

[5] RockDB Tuning Guide. https://github.com/facebook/rocksdb/wiki/RocksDB-Tuning-Guide

[6] Advanced RocksDB State Backend Options. https://ci.apache.org/projects/flink/flink-docs-stable/ops/config.html#advanced-rocksdb-state-backends-options

[7] RocksDB 笔记. http://alexstocks.github.io/html/rocksdb.html

注意事项

- 上述配置参数和公式仅供参考,实际配置时需要根据具体的硬件环境、工作负载和数据特性进行调整。

- 在调整参数之前,建议进行充分的性能测试和基准测试,以评估不同配置对性能的影响。

- 定期监控系统性能指标(如CPU使用率、内存使用率、磁盘I/O等),以便及时发现并解决潜在的性能瓶颈。

总之,优化RocksDB的参数配置是一个持续的过程,需要根据实际应用场景和需求进行调整和优化。

九、RPC传输优化

RPC(远程过程调用)传输的优化方式主要包括以下几个方面:

使用单一长连接

- 长连接 :减少TCP连接的建立和关闭次数,降低系统开销,提高传输效率。

优化Socket通信

- 非阻塞I/O :使用Netty等框架实现非阻塞I/O,提高并发处理能力。

- 零拷贝技术 :减少数据在内存中的复制次数,提高数据传输效率。

序列化与反序列化优化

- 高效序列化协议 :使用Protocol Buffers、FlatBuffers等高效序列化协议,减少数据传输量和处理时间。

连接池的使用

- 连接池 :复用TCP连接,减少连接建立和关闭的开销,提高性能。

负载均衡和故障转移

- 负载均衡 :通过负载均衡算法分散请求到不同的服务器,提高系统的可用性和可靠性。

- 故障转移 :在服务器出现故障时,自动将请求转发到其他健康服务器,确保服务的连续性。

异步通信

- 异步通信模式 :提高资源利用率和响应速度,适用于高并发场景。

数据压缩

- 数据压缩技术 :减少网络带宽的占用,提高传输效率。

调整操作系统和硬件

- 内核参数调整 :优化TCP缓冲区大小、文件描述符限制等,提高网络性能。

- 硬件升级 :使用高性能的网络设备和存储设备,减少延迟和提高吞吐量。

总结

Nebula Graph性能优化需要从多方面入手,包括硬件资源(如内存、CPU、存储设备)的合理配置与升级;查询优化,像精简查询语句、善用索引、开展并行与分布式查询;数据模型设计要合理,控制数据膨胀;存储引擎方面,依据需求选用并调整参数;资源管理和调度上要动态分配、均衡负载;系统架构上考虑分布式和水平扩展以及数据分片;同时借助性能监控工具及时发现问题并配合定期的数据清理和备份工作来全面提升性能。

以上大纲起到一个抛砖引玉的作用,每一章节一条展开来都是一个值得研究的性能优化方向。

END

本文参与 「有奖征文」2024年,我和 NebulaGraph 一起,欢迎点赞评论区交流