Nebula Version : 2.0-Beta

Spark-submit standalone测试环境:一台机器上的三个docker容器(docker与spark一台机器上)(在某一个docker中submit)

Submit Yarn的环境:nebula server(三台机器(HDD)),spark submit在一个Yarn集群上

standalone提交:

$SPARK_HOME/bin/spark-submit \

--master spark://master:7077 \

--class com.vesoft.nebula.exchange.Exchange \

/opt/Code/nebula/nebula-exchange-2.0.0.jar \

-c /opt/Code/nebula/test2/app.conf

在公司的yarn-cluster提交:

/usr/bin/hadoop/software/spark2.4/bin/spark-submit \

--master yarn-cluster \

--class com.vesoft.nebula.exchange.Exchange \

nebula-exchange-2.0.0.jar \

-c json_app.conf

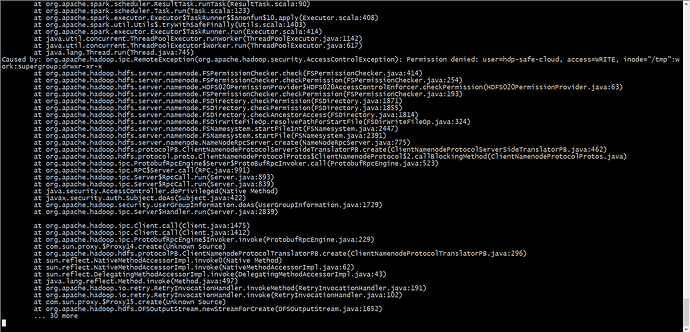

报错:

3:09:09 INFO ApplicationMaster: Preparing Local resources

21/01/15 13:09:10 INFO ApplicationMaster: ApplicationAttemptId: appattempt_1608801054019_1051147_000004

21/01/15 13:09:10 INFO ApplicationMaster: Starting the user application in a separate Thread

21/01/15 13:09:10 INFO ApplicationMaster: Waiting for spark context initialization...

21/01/15 13:09:10 ERROR ApplicationMaster: User class threw exception: java.lang.IllegalArgumentException: json_app.conf not exist

java.lang.IllegalArgumentException: json_app.conf not exist

at com.vesoft.nebula.exchange.config.Configs$.parse(Configs.scala:213)

at com.vesoft.nebula.exchange.Exchange$.main(Exchange.scala:67)

at com.vesoft.nebula.exchange.Exchange.main(Exchange.scala)

at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:62)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)

at java.lang.reflect.Method.invoke(Method.java:497)

at org.apache.spark.deploy.yarn.ApplicationMaster$$anon$2.run(ApplicationMaster.scala:685)

21/01/15 13:09:10 INFO ApplicationMaster: Final app status: FAILED, exitCode: 13, (reason: User class threw exception: java.lang.IllegalArgumentException: json_app.conf not exist

at com.vesoft.nebula.exchange.config.Configs$.parse(Configs.scala:213)

at com.vesoft.nebula.exchange.Exchange$.main(Exchange.scala:67)

at com.vesoft.nebula.exchange.Exchange.main(Exchange.scala)

at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:62)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)

at java.lang.reflect.Method.invoke(Method.java:497)

at org.apache.spark.deploy.yarn.ApplicationMaster$$anon$2.run(ApplicationMaster.scala:685)

)

21/01/15 13:09:10 ERROR ApplicationMaster: Uncaught exception:

org.apache.spark.SparkException: Exception thrown in awaitResult:

at org.apache.spark.util.ThreadUtils$.awaitResult(ThreadUtils.scala:227)

at org.apache.spark.deploy.yarn.ApplicationMaster.runDriver(ApplicationMaster.scala:469)

at org.apache.spark.deploy.yarn.ApplicationMaster.org$apache$spark$deploy$yarn$ApplicationMaster$$runImpl(ApplicationMaster.scala:305)

at org.apache.spark.deploy.yarn.ApplicationMaster$$anonfun$run$1.apply$mcV$sp(ApplicationMaster.scala:245)

at org.apache.spark.deploy.yarn.ApplicationMaster$$anonfun$run$1.apply(ApplicationMaster.scala:245)

at org.apache.spark.deploy.yarn.ApplicationMaster$$anonfun$run$1.apply(ApplicationMaster.scala:245)

at org.apache.spark.deploy.yarn.ApplicationMaster$$anon$3.run(ApplicationMaster.scala:780)

at java.security.AccessController.doPrivileged(Native Method)

at javax.security.auth.Subject.doAs(Subject.java:422)

at org.apache.hadoop.security.UserGroupInformation.doAs(UserGroupInformation.java:1657)

at org.apache.spark.deploy.yarn.ApplicationMaster.doAsUser(ApplicationMaster.scala:779)

at org.apache.spark.deploy.yarn.ApplicationMaster.run(ApplicationMaster.scala:244)

at org.apache.spark.deploy.yarn.ApplicationMaster$.main(ApplicationMaster.scala:804)

at org.apache.spark.deploy.yarn.ApplicationMaster.main(ApplicationMaster.scala)

Caused by: java.lang.IllegalArgumentException: json_app.conf not exist

at com.vesoft.nebula.exchange.config.Configs$.parse(Configs.scala:213)

at com.vesoft.nebula.exchange.Exchange$.main(Exchange.scala:67)

at com.vesoft.nebula.exchange.Exchange.main(Exchange.scala)

at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:62)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)

at java.lang.reflect.Method.invoke(Method.java:497)

at org.apache.spark.deploy.yarn.ApplicationMaster$$anon$2.run(ApplicationMaster.scala:685)

21/01/15 13:09:10 INFO ApplicationMaster: Deleting staging directory hdfs://namenode.safe.lycc.qihoo.net:9000/home/yarn/spark/cache/hdp-safe-cloud/.sparkStaging/application_1608801054019_1051147

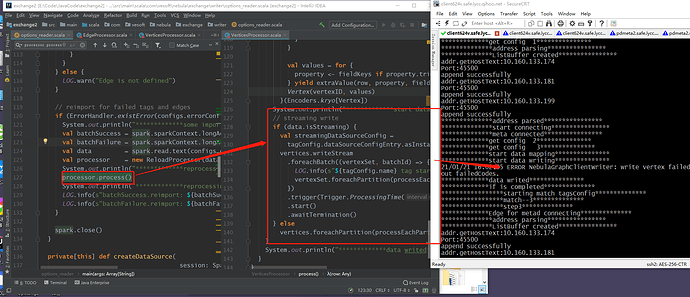

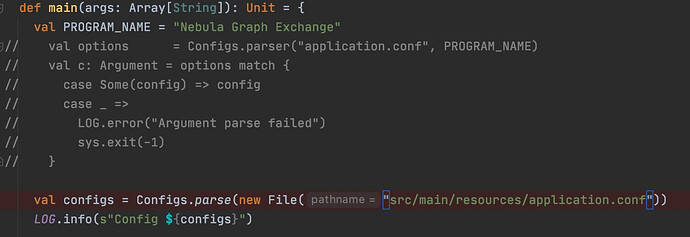

就是我想知道后面的 -c 是jar包的配置,他的路径该填哪里,我之前以standalone模式,在本地是可以的,现在换到yarn-cluster上面就出错了。

:

: