你好, 我不是很理解这个目录的分区存储结构, 希望解惑下, 问题件第二张照片

- show hosts 结果

2 .3台机器, 其中一台的数据存储目录结构

谢谢!

data/storaged1/nebula 下面的是space的目录,有7个目录表示你有7个space。

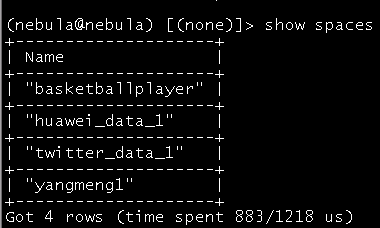

你好, 你说的space是这个吗? 我建立的就4个, 还有系统隐藏的吗??

是不是23号创建的那三个space被删除了?

好像, 我有重复导入过篮球实例的脚本, 应该是drop了2次, 但还drop space 不应该自动删除对应的目录吗?

还有这个space的编号是随便的数字吗?

我有重复导入过篮球实例的脚本, 应该是drop了2次, 但还 drop space 不应该自动删除对应的目录吗?

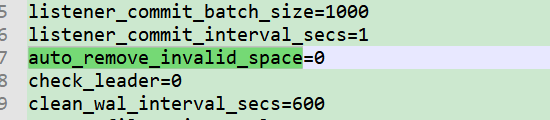

现在 drop space 是有个开关控制的 auto_remove_invalid_space,默认是不删除 space 的目录的,假如开关开启的话,也是重启之后才删除。

还有这个space的编号是随便的数字吗?

space 的 id 是全局唯一的,会在集群内自增。

找到了, 谢谢, ![]()

对了顺便咨询下你, 关于 “快照” 和 “backup&restore” 有什么时间性能上的测试结果吗? 该怎么选呢? 比如上T级别的数据选用哪种性能更好呢??

现在的快照是针对本地备份,而 backup&restore 支持本地备份也支持异地备份。对于你的使用场景,你假如考虑的是机器硬盘异常导致的数据丢失,那么这种情况,只能选择 backup&restore。假如你只是怕你们数据写错想要恢复上一时刻的数据,那么你可以直接打快照就可以。

我们之前使用的neo4j的备份场景都是本地加异地, 那不考虑场景, 新能方面呢??? 那个更快?

快照和全量备份都是通过打快照,所以是一样的。

这个就是作用域的问题,但是实现是一样的。

好的好的, 感谢

你好:

咨询下你, 关于扩容存储, 我在论坛上找的方法, 是不是先docker service rm all服务, 在修改yaml文件添加新的storage4, 再重启创建服务, 可行吗? 不会丢数据吧?

谢谢

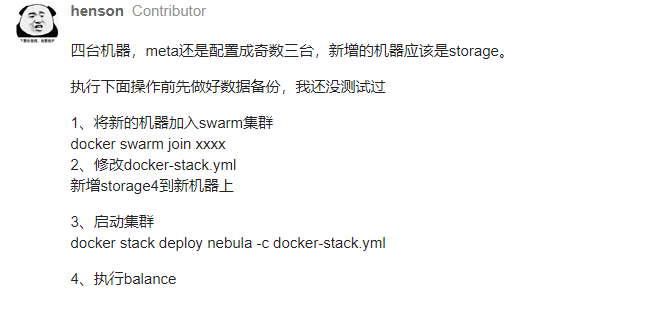

你是在一个机器上面有 docker-compose 管理多个 storage 容器吗?假如是这样,这个扩容的意义在哪?你不应该是用swarm机器,用不同机器吗?同个机器起多个容器做集群只是给用户快速使用集群而已,正常生产,这样用的意思是什么?

你好, 不好意思, 我没说明白的配置

你只要确保你新加的storage配置文件里的 meta_server_addrs 和你其他storage配置的一样就可以,然后你的storage加进去后,你只需要按照文档操作就可以

https://docs.nebula-graph.com.cn/2.0.1/8.service-tuning/load-balance/

你新加的 storage只要加进你的 swarm 中,通信没有问题,会自动连上metad的,你执行show hosts 应该能看到新加的机器的信息的