- nebula 版本:(为节省回复者核对版本信息的时间,首次发帖的版本信息记得以截图形式展示)

- 部署方式(分布式 / 单机 / Docker / DBaaS):分布式

- 是否为线上版本:Y / N

- 硬件信息

- 磁盘( 推荐使用 SSD)SSD

- CPU、内存信息 96C 256G

- 问题的具体描述

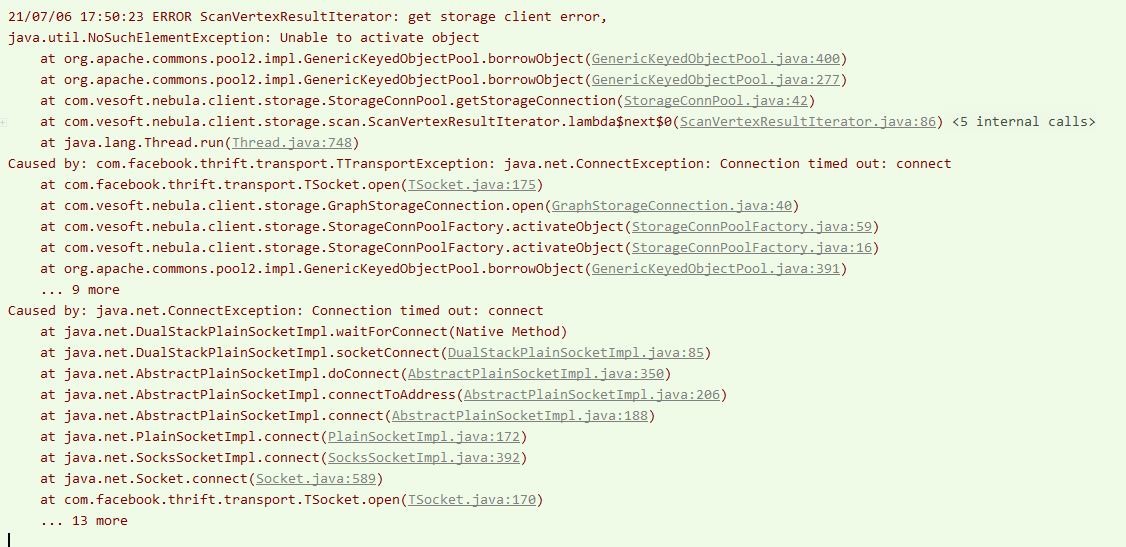

- 相关的 meta / storage / graph info 日志信息(尽量使用文本形式方便检索)

本地开发运行timeout,将程序打包上传到服务器上则可以正常运行。

使用spark-connector读取数据,无法连接到storage,一直重试,一直报错。

有遇到metaclient链接timeout的问题,但是我调整代码增加了timeout就可以了。

防火墙也关闭了,不知道是网络的问题还是storage配置的问题,是否有排查的思路。。。

代码如下: