space partition的数量太少了吧

改了也没用。之前一个小时跑完的任务,更新版本后10个小时都跑不完

384个

绝望啊 导数据太慢了 线上业务都停滞了。。

“STORAGE” | “rocksdb_column_family_options” | “map” | “MUTABLE” | {disable_auto_compactions: true, max_bytes_for_level_base: “268435456”, max_write_buffer_number: “4”, write_buffer_size: “67108864”} |

大佬 改这个配置会有效果不

你把 Exchange 的日志(就在控制台)贴一下

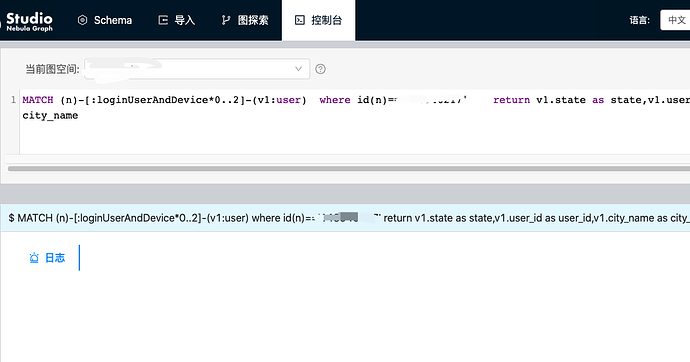

???哪个控制台

控制台怎么会有Exchange的日志,请大佬说详细点。。

你咋用 Exchange 呢,就是那个编辑器的控制台。Studio 是用来做可视化的

leader分布呢?

- 你如果使用exchange做导入,日志就在你提交spark任务的终端打印出来

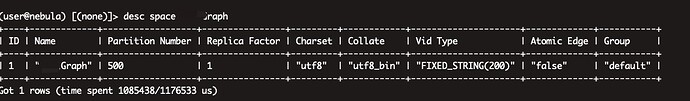

- 你执行下desc space xxx 截图发下;执行下use xxx; show parts 截图发下

- 你的速度慢是 2.0.0 与nightly对比慢,还是同在2.0.0版本的前提下,点快边慢? 这点麻烦确认并回复下

- 速度慢和快的时候,数据集是否有变动,exchange 的配置是否有变动, 导入的space 是否不同,这几点回复下

- 导入速度很慢时,把Exchange导入的日志发过来。

为有效定位问题并解决问题,麻烦确认并回复上面的几个问题。

1和5:不报错的话就这两行:

、log4j:WARN No such property [datePattern] in org.apache.log4j.RollingFileAppender.

Warning: Ignoring non-spark config property: Spark.memory.fraction=0.6

2.desc space xxx

show parts

3.速度慢是2.0.0版本比nightly版本慢,在同类型边或节点的前提下;

4.数据集无变动、exchange无变动、space一样的配置

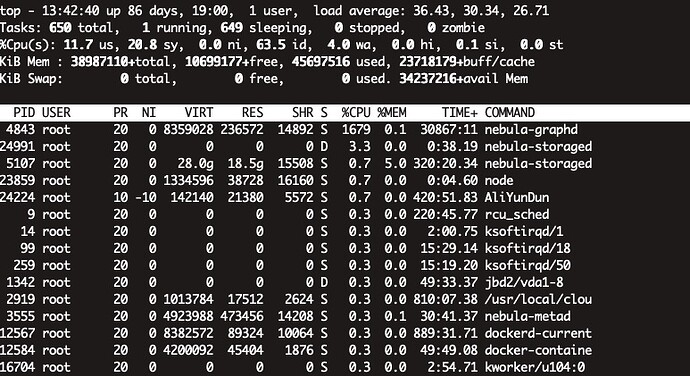

你在没有做任何操作的情况下看下storaged服务的cpu使用率,你的show parts结果中有几个part没有leader, 你的服务是不是一直在做compact?

ps:你看下spark的配置,在SPARK_HOME/conf/log4j.properties 文件中 是不是把spark日志配置到文件中了,如果配到文件中了就去对应位置看日志。

导数据的任务已经停了。500个part很多都没有leader

看下这个

开了好多镜像会不会影响性能?

你是在做查询么,graphd cpu使用率这么高