- nebula 版本:2.0.0

- 部署方式 Docker

- 是否为线上版本:Y

- 问题的具体描述

使用nubula-spark-connector 2.0.0 reader数据,只读到部分数据,日志有ERROR如下:

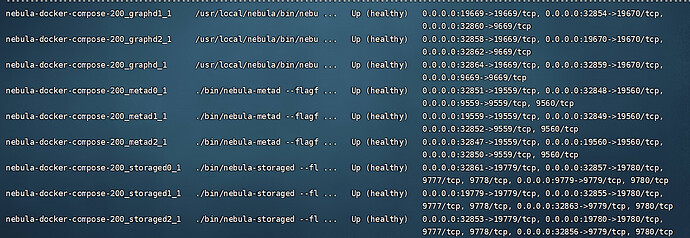

spark是本地windows版本,之前用来write数据无误,docker服务如下:

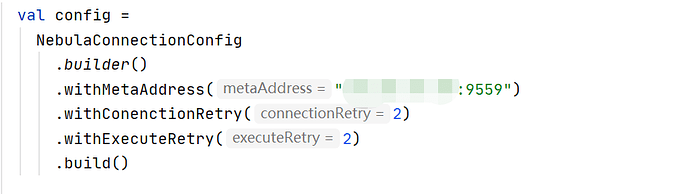

连接配置如下:

其中 9559/19559/19560 端口均做了端口映射,求教一下问题出在哪里呢,是不是部署哪里没有做好

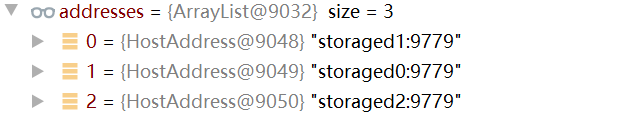

storage处的host如下,docker部署在单机上

addresses中的storaged0、storaged1、storaged2是docker内部的地址,相当于三个服务, 你不能在本地配置hosts的。

一般如果要使用storage client,不建议docker来部署服务。 你这种配置相当于每次都去一个storage实例上读取,而该实例又不是part的leader就会错误。