脏点关联百万边删除无效:

问题:

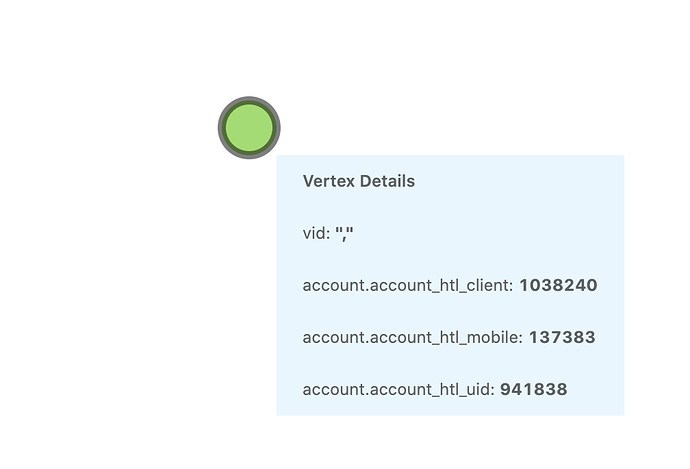

- 如下id为 “,”的脏点,关联了200w个脏边,目标利用已有脏数据的全部边导入信息,删除这个脏点关联的全部边

途径:

- 通过spark-connector执行任务,先查询边是否存在,存在则删除。

结果:

- 任务正常执行成功,并做compaction。查询涉及到脏数据的边发现只有部分删除。日常不涉及脏数据的普通数据删除是没有问题的。这种使用spark大量删除同一顶点相关边数据是否有问题。请教下如何稳妥删除这200w边呢强调文本

- nebula 版本:2.5

- 部署方式:3台SSD 三副本分布式

- 安装方式: RPM

- 是否为线上版本:Y

- 硬件信息

- 磁盘( SSD)

- CPU、内存信息

- 数据总量 70亿