- nebula 版本:3.1.0

- 部署方式:分布式

- 安装方式:operator

- 是否为线上版本:Y

用helm部署operator 1.1.0, 发现nebula-operator-system 空间下pod拉取镜像都是失败的

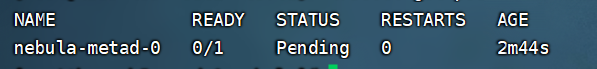

拿其中一个pod为例子

用helm部署operator 1.1.0, 发现nebula-operator-system 空间下pod拉取镜像都是失败的

图片不显示,重新上传下~

可以看见了吗 我这边是可以看见的

我编辑了你的帖子。。你用了代码包裹图片(自然是显示不正确了)你等等哈,研发同学等会回你。

好的,替换了之后operator的pod都正常了,多谢。但是创建storageClass后,创建apps_v1alpha1_nebulacluster.yaml集群,会有

,pod的日志为

,pod的日志为

我重新创建了一个nfs-provisioner,然后创建了一个gp2何其关联,结果还是上面的报错。

apiVersion: apps/v1

kind: Deployment

metadata:

name: nfs-client-provisioner

labels:

app: nfs-client-provisioner

namespace: nebula-cluster #与RBAC文件中的namespace保持一致

spec:

replicas: 1

selector:

matchLabels:

app: nfs-client-provisioner

strategy:

type: Recreate

selector:

matchLabels:

app: nfs-client-provisioner

template:

metadata:

labels:

app: nfs-client-provisioner

spec:

serviceAccountName: nfs-client-provisioner

containers:

- name: nfs-client-provisioner

image: quay.io/external_storage/nfs-client-provisioner:latest

volumeMounts:

- name: nfs-client-root

mountPath: /persistentvolumes

env:

- name: PROVISIONER_NAME

value: nfs-provisioner #provisioner名称,请确保该名称与 nfs-StorageClass.yaml文件中的provisioner名称保持一致

- name: NFS_SERVER

value: 10.128.1**.2** #NFS Server IP地址

- name: NFS_PATH

value: /data/share/nebula #NFS挂载卷

volumes:

- name: nfs-client-root

nfs:

server: 10.128.1**.2** #NFS Server IP地址

path: /data/share/nebula #NFS 挂载卷

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: gp2

provisioner: nfs-provisioner

parameters:

archiveOnDelete: “true” # false表示pv被删除时,在nfs下面对应的文件夹也会被删除,true正相反

reclaimPolicy: Retain

allowVolumeExpansion: true

mountOptions:

求教,哭了,太难了

我之前只是弄过 hostpath provider 好像是行的,让 cloud 雷老师帮忙瞅瞅哈,别担心

不部署成功夜不能寐啊,哈哈哈,谢谢咯

gp2是aws提供的storageClass名称,看你的步骤,应该是有问题的,建议直接用helm来部署nfs驱动的存储

$ helm repo add nfs-subdir-external-provisioner https://kubernetes-sigs.github.io/nfs-subdir-external-provisioner/

$ helm install nfs-subdir-external-provisioner nfs-subdir-external-provisioner/nfs-subdir-external-provisioner \

--set nfs.server=10.128.1**.2** \

--set nfs.path=/data/share/nebula

您好 我是按照网上的指南创建storageClass的,包括创建了ServiceAccount、roleBinding这些 :sob,这几个的配置文件是

rbac.yaml (1.8 KB)

,然后创建了nfs-provider和名为gp2的storageClass,配置文件之前已经贴了,请问一下是哪个步骤不对呢

要不然你删了手动弄的 sc 的resource,直接用上边Kevin 老师的 nfs-provider 的 helm?

或者用这个我在 nebula-operator-kind(还没支持新版本) 基于 hostpath 的

我理解反正也不是生产的,可以很快搞起来

helm已经把这些都集成好了,不需要自己一步步的配置,防止出错

嗯嗯 感觉就是nfs-provider没有弄好,pvc申请不到pv

是不是 github pages 你那里访问不了呀

curl https://kubernetes-sigs.github.io